|

Inicio |

|

|

|

|

NOTICIAS

CIENTÍFICAS

Octubre 2010

TITULARES DE LAS NOTICIAS DEL MES

Creadas células "zombies" que se activan con luz

El Sol desde otra perspectiva

Las "buckybolas" pueden ser el origen

de la vida

La última frontera del universo

Mundos oscuros en los confines del universo

La ciencia se acerca a la lectura

del pensamiento

Hallan la estrella de neutrones más masiva

El rayo que nos cambió la vida

Textiles inteligentes integrados en redes

inalámbricas para ocio y salud

¿Y si el

universo fuera un hologroma?

Vegetación autóctona clave para recuperar territorios contaminados

Bienvenidos a la segunda era espacial

La NASA descubre plata en la cara oculta de la Luna

El LHC busca universos paralelos

"Esto

puede ser muy parecido a `Gran Hermano´"

La sonda LCROSS confirma la presencia de agua helada en la Luna

La ONU pesimita con respecto a los acuerdos de Cancún

La nueva "arca de Noé" es una torre de 100

metros

El canibalismo del "Tiranosaurio rex"

Cazando leones en Atapuerca

"Las matemáticas siempre han ayudado al progreso de las ciencias"

El nitrógeno

antropogénico, una amenaza para la flora y la fauna

Un yacimiento de gas junto al "Prestige"

Objetivo: detectar el cáncer en la sangre

La mano de obra sale a 4,6 euros por iPhone en China

EEUU trata al primer paciente con células madre embrionarias

"No

he visto un nivel de destrucción así en mi vida"

El primer ministro húngaro habla de "negligencia humana" tras el

vertido tóxico

Google diseña un coche

sin conductor

Naves interestelares: un grupo de científicos

diseña una máquina para ir más allá del Sol

Mil millones

de toneladas de hielo del polo Sur para observar neutrinos

Aragón registra un caso de malaria autóctono

El vertido tóxico ya alcanza el Danubio

Terremotos: ¿esta la naturaleza fuera de control?

California tiembla por la amenaza del "Big

One"

Así robó el Sol a Marte su atmósfera

La fuga de una sustancia tóxica deja al menos tres muertos en

Hungría

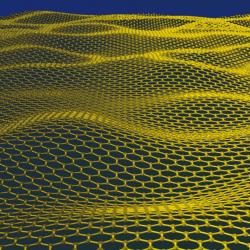

Nobel de Física para dos científicos rusos por sus

trabajos sobre el grafeno

Los océanos pueden esconder 750000 especies marinas

La mosca de la fruta se expandió por el mundo desde África

Nuevo telescopio de rayos X para estudiar agujeros negros

Pseudociencia en el campus

La muerte de un planeta

Los dinosaurios que surgían de la tierra

Archivo

-Creadas células "zombies" que se activan con luz

|

|

|

Un equipo de la Universidad Duke (EEUU) ha desarrollado

células que cambian su estado cuando se les proyecta un simple rayo de luz

azul. La investigación, publicada en Nature Methods, tiene el

objetivo de desarrollar células modificadas que puedan regenerar tejido

cerebral dañado o incluso segregar un medicamento en tejidos enfermos, según

Chandra Tucker, investigadora principal del proyecto. Se

trata de una técnica a muy largo plazo cuyos primeros frutos se centrarán en

la investigación básica o animal, reconocen los autores.

Los investigadores usaron células de levadura, así como células de hígado

y del cerebro de ratones. Introdujeron en ellas dos proteínas de la planta

Arabidopsis thaliana. Cuando se exponen a la luz, las proteínas se

activan dentro de las células, lo que podría ayudar a controlar sus

funciones. Hasta ahora, los trabajos previos en este campo necesitaban

inocular otros productos en las células modificadas para que sus

interruptores se encendiesen o apagasen cuando se les aplicaba luz.

"Este nuevo sistema, con una de las moléculas ya dentro de las

células, hace mucho más fácil construir un interruptor de luz",

explica Tucker. El interruptor de Tucker permite controlar la

interacción de diferentes proteínas dentro de las células.

Si se logra perfeccionar la técnica, podría contribuir a que células

enfermas se suicidasen o que otras segregasen medicamentos a zonas dañadas.

Como también funciona en células cerebrales, se podrían reconstruir

conexiones neuronales |

Fuente:

publico.es, 31-10-10

-El

Sol desde otra perspectiva

|

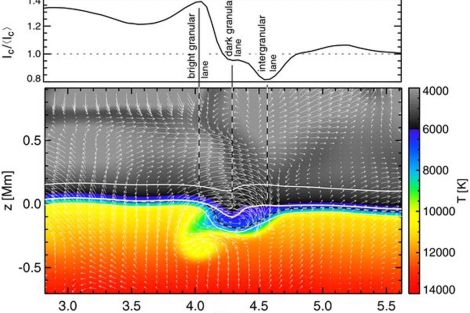

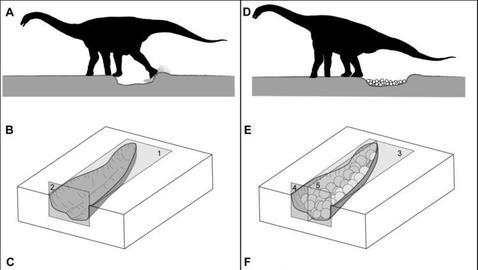

Esquema de un torbellino horizontal (las flechas

representan la velocidad). | CSIC

|

|

El telescopio solar Sunrise ha desvelado una

"inesperada" actividad en el Sol, según los primeros resultados

de esta misión publicados en doce artículos en la revista

The

Astrophysical Journal Letters.

La misión, cuyos resultados

proceden en su mayoría del magnetógrafo IMaX, diseñado

y construido en España, ha revelado una "espectacular" actividad en

regiones de la superficie solar que se consideraban en calma. El

magnetógrafo es el instrumento que registra los componentes del campo

magnético de un astro y fue construido bajo la dirección del

Instituto de Astrofísica de

Canarias y con la participación de la

Universidad de

Valencia, el

Instituto

Nacional de Técnica Aeroespacial y el

Instituto de Astrofísica de

Andalucía.

"Tan sólo con el análisis de dos períodos de observación de media

hora cada uno hemos obtenido resultados espectaculares, la mayoría con

datos de IMaX/Sunrise, lo que constituye un verdadero éxito de

la misión y de la tecnología desarrollada por el equipo español",

ha remachado el investigador del

CSIC José

Carlos del Toro.

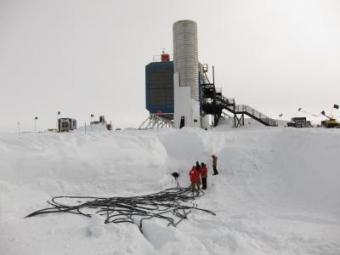

El

telescopio Sunrise, durante

un viaje de cinco días en globo circunvolando el Ártico, estudió la

superficie solar con una resolución sin precedentes, de casi 100

kilómetros. Despegó en junio de 2010 desde Suecia y se situó durante

cinco días a una altura de 40 kilómetros sobre la superficie terrestre. |

Varios hallazgos

Los recientes resultados aportan luz a algunos de los más antiguos

problemas de la física solar, como el calentamiento de la cromosfera, la

capa inmediatamente superior a la fotosfera, la superficie del Sol.

Hasta ahora se desconocía por qué, si la temperatura de la fotosfera se

estima en 6.000 grados, en la cromosfera se alcanzaban hasta 20.000. IMaX/Sunrise

ha hallado que en las regiones por debajo de la fotosfera se produce

el doble de energía acústica de lo que se pensaba, "lo que se

acerca a los valores necesarios para explicar el calentamiento cuando dicha

energía se transporta hacia arriba".

Esta energía se produce por los movimientos convectivos en el Sol, es

decir, por material caliente que asciende hacia la superficie, se enfría y

vuelve a descender. Esta convección genera cambios de presión que se

propagan en forma de ondas que, al transportarse, liberan energía

térmica y aumentan la temperatura. IMaX/Sunrise también ha

permitido obtener pruebas directas de la existencia de tubos de

flujo magnético a pequeña escala, considerados los ladrillos del

magnetismo solar desde los años 70, pero cuya existencia había sido

imposible de demostrar de forma directa por su pequeño tamaño. Otro de los

hallazgos se relaciona con la granulación solar, fenómeno

producido por el gas caliente que sube hacia la superficie desde el interior

solar (similar al burbujeo del agua al hervir) y que se manifiesta en forma

de gránulos con un tamaño medio de aproximadamente 1.000 kilómetros y una

duración de cinco minutos.

Se han descubierto torbellinos horizontales que avanzan a través de las

celdas de los gránulos y pequeñas estructuras magnéticas horizontales que

aparecen y desaparecen. En definitiva, Sunrise "ofrece una

panorámica del Sol inédita y caracterizada por una actividad

constante a pequeña y gran escala", según Del Toro. En un segundo vuelo,

previsto para 2013, Sunrise completará una trayectoria alrededor del polo

Sur de entre 12 y 14 días.

Fuente: elmundo.es, 30-10-10

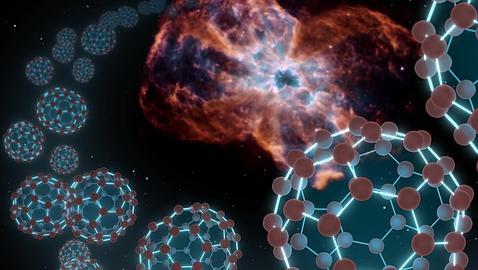

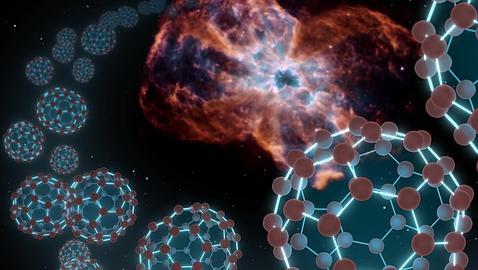

-Las "buckybolas" pueden ser el origen

de la vida

El pasado mes de julio, el

telescopio Spitzer de la NASA descubrió en una nebulosa planetaria un

raro fenómeno que nunca antes había sido hallado en el espacio.

Consiguió detectar «buckybolas», unas moléculas de carbono con forma de

balón de fútbol y con propiedades únicas cuya existencia más allá de la

atmósfera resultaba una auténtica sorpresa. El asombro fue tan grande que

los científicos llegaron a plantearse que podría tratarse de algo

anecdótico, y que, simplemente, habían tenido suerte al encontrarlas. Nada

de eso. Estas esferas de carbono no solo existen allá arriba, sino que son

muy abundantes. El Spitzer las ha encontrado alrededor de tres estrellas

moribundas en la Vía Láctea y cerca de una cuarta en una galaxia cercana,

donde hay tantas que su masa equivale a quince lunas como la nuestra. El

hallazgo puede tener importantes repercusiones en la comprensión de cómo se

formó la vida en la Tierra.

|

Las

«buckybolas», también conocidas como

fullerenos, son moléculas que constan de 60 átomos de carbono

unidos. Toman su nombre del parecido con las cúpulas geodésicas del

arquitecto Buckminster Fuller, como las que se encuentran en la entrada

del parque temático Epcot de Disney, en Orlando, Florida (EE.UU.). Estas

esferas en miniatura fueron descubiertas por primera vez en un

laboratorio hace 25 años, y son muy comunes en el hollín de las velas y

en las capas de rocas y meteoritos, pero no fue hasta el pasado julio

que pudo confirmarse su existencia en el espacio.

«Resulta que las

buckybolas son mucho más comunes y abundantes en el Universo de lo que

inicialmente se pensaba», explica la astrónoma Letizia Stanghellini, del

Observatorio Nacional de Astronomía Óptica en Tucson, Arizona. «Spitzer

las había encontrado recientemente en una posición específica, pero

ahora las hemos visto en otros entornos. Esto tiene implicaciones para

la química de la vida.

Es posible que las buckybolas del espacio exterior proporcionaran las

semillas para la vida en la Tierra». |

|

|

Quince veces la masa de la Luna

Los investigadores,

liderados por Aníbal García-Hernández, del

Instituto de Astrofísica de Canarias, encontraron las esferas alrededor

de tres estrellas moribundas similares al Sol, conocidas como nebulosas

planetarias, en nuestra Vía Láctea. Todas las nebulosas donde se han

detectado buckybolas son ricas en hidrógeno. Esto contradice lo que los

investigadores han pensado durante décadas, ya que creían que el hidrógeno

contaminaría el carbono, provocando que se formasen cadenas y otras

estructuras en lugar de esferas.

El equipo también

localizó estas bolas en una nebulosa planetaria dentro de una galaxia

cercana conocida como

Pequeña Nube de Magallanes. Y hay muchísimas: juntas tienen un 2% la

masa de la Tierra, lo que es lo mismo a

quince veces la masa de la Luna.

Cestas para la vida

Las implicaciones de este

descubrimiento son de gran alcance. Los científicos han especulado en el

pasado con las buckybolas, las cuales pueden actuar como cestas para

moléculas y átomos, y podrían haber transportado sustancias a la Tierra para

el inicio de la vida. Las pruebas para esta teoría proceden del hecho de que

se han encontrado buckybolas en meteoritos que portan gases extraterrestres.

«Las buckybolas son una

especie de diamantes con agujeros en el centro», dice Stanghellini. «Son

unas moléculas increíblemente estables y difíciles de destruir, y podrían

transportar otras moléculas interesantes en su interior. Esperamos aprender

más sobre el importante papel que pueden desempeñar en la muerte y el

nacimiento de estrellas y planetas, y tal vez en la propia vida».

En la Tierra, el estudio de estas

moléculas se aplica a la investigación en fármacos, superconductores,

dispositivos ópticos y potabilización de agua, entre otros ejemplos.

Fuente: abc.es, 29-10-10

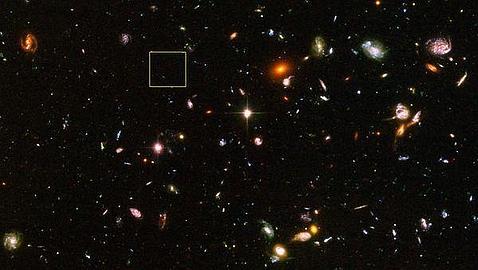

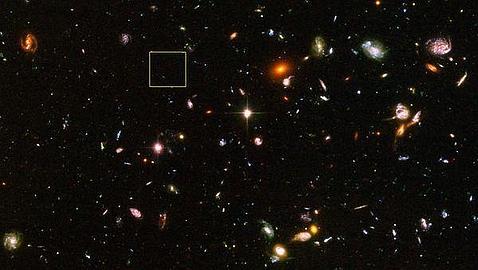

-La última frontera del universo

Un mínimo punto de luz, casi invisible, indetectable

durante miles de millones de años, aparece de pronto en el fondo negro del

Universo. Como un signo de puntuación escrito en el espacio, los telescopios

dejan de leer para detenerse y enfocar lo más posible sus objetivos. Esa

pequeña nota luminosa es el objeto más distante jamás detectado, una galaxia

de complejo nombre bautizada como UDFy-38135539, cuya luz

ha tardado 13.000 millones de años en llegar a la Tierra. Ningún cuerpo

celeste más lejano ni más antiguo ha sido visto jamás por el ser humano.

A medida que las técnicas de detección se han ido

desarrollando, los astrónomos han sido capaces de encontrar objetos cada vez

más lejanos en el espacio; galaxias, estrellas o quasares que aparecieron

apenas unos cientos de millones de años después de la gran explosión del Big

Bang, cuando el Cosmos, mucho más pequeño y menos «concurrido», era muy

diferente del que hoy conocemos, y la aparición de la Tierra ni siquiera

estaba apuntada en la agenda de la creación.

|

En el centro del cuadrado blanco galaxia más lejana de la

conocidas |

|

La galaxia que ha batido todos los records

fue detectada por primera vez por la nueva Cámara de Gran Angular 3 (WF3)

del telescopio espacial Hubble en 2009. Ahora, científicos del

Observatorio Europeo Austral (ESO) han confirmado en una investigación

publicada en la revista Nature, su antiquísima naturaleza. No ha sido nada

fácil dar con ella, ya que su luz, emitida tan sólo 600 millones de años

después del Big Bang, ha llegado a la Tierra de forma extremadamente

débil, en gran parte porque hasta esa época una densa nube de hidrógeno

neutro cubría casi todo el Universo.

Descubrirla es como encontrar una aguja en una pajar... lleno de niebla.

Para ello, han utilizado la técnica de espectroscopia, la más fiable para

echarle años a las galaxias.

«Estamos asistiendo, si no a la primera

generación de estrellas, a una de las primeras que aparecieron en el

Universo, y eso tiene un impacto cosmológico muy fuerte», explica Miguel

Mas Hesse, investigador del Centro de Astrobiología (INTA-CSIC). Es

cierto. La carrera de hallazgos ha sido impresionante en los últimos diez

años. La última galaxia ha desbancado en el puesto de objeto más lejano a

una estrella descubierta el pasado año, cuya muerte en forma de estallido

de rayos gamma, una potente explosión de energía, llegó a la Tierra tras

viajar también cerca de 13.000 millones de años. A su vez, este «ejemplar

de Neandertal», como fue descrita por los científicos españoles que

participaron en su detección, le quitó el puesto a una lista de galaxias y

quasares formados cuando el Universo tenía de 700 a 800 millones de años. |

La edad oscura

Ahora, los científicos se enfrentan a un reto aún

mayor, descubrir objetos de un tiempo incluso anterior, cuando el Universo

entero no tenía más de 500 millones de años, estructuras que pertenecen al final

de la llamada «edad oscura», la época tras la que aparecieron las primeras

estrellas y de la que se aún se sabe muy poco. «Estamos seguros de que en los

próximos años, con los instrumentos que ya tenemos -entre ellos destaca el Gran

Telescopio de Canarias-, vamos a ser capaces de alcanzarlo», augura Mas. Pero

serán dos grandes telescopios, el espacial James Webb, que se lanza en 2014,

optimizado para trabajar en la longitud de onda en la que llegan las emisiones

de este tipo de estrellas «arqueológicas», y el potentísimo y gigantesco E-ELT,

que abrirá su gran ojo tres años más tarde en Chile, los que podrán analizar en

profundidad estas maravillas . Cuando entren en funcionamiento, el Universo

tendrá menos secretos.

Los objetos más antiguos tras el Big Bang:

1) 13.074 millones de años: La galaxia UDFy-38135539, descubierta en

2009, es el objeto más lejano y antiguo

2) 13.035 millones de años: El estallido de rayos gamma GRB 090423, en

cuyo descubrimiento participó el CSIC

3) 12.968 millones de años: Galaxia A1689-zD1. Su edad pudo ser

confirmada hace un par de años

4) 12.888 millones de años: Galaxia A2218, donde se forman estrellas

masivas de manera intensa

5) 12.882 millones de años: Galaxia OIK 1. Su edad fue confirmada por

espectroscopia en 2006

6) 12.797 millones de años: El quásar CFHQS J2329-031, una galaxia

dominada por un agujero negro muy masivo.

Las capas de cebolla¿Cómo saben los científicos que

lo que o es tan lejano y antiguo? Básicamente, el quid de la cuestión lo tiene

un fenómeno de la Física llamado

corrimiento al rojo, que pone a cada objeto su medalla en el ranking.

«Cuanto más lejos está un objeto, su espectro se desplaza hacia las longitudes

de onda del rojo, lo que permite calcular la distancia a la que se encuentra»,

indica Miguel Mas. La galaxia ganadora tiene un corrimiento al rojo de 8,6; la

estrella en segunda posición, uno de 8,2. «Hace diez años, el límite estaba

tan solo en 2 ó 3, lo que demuestra lo mucho que hemos avanzado». señala el

investigador del CSIC. «Es como quitar capas a una cebolla -continua-, cuanto

más lejos están los objetos vamos más atrás en el tiempo y podemos conocer

cómo ha evolucionado el Universo».

Fuente: abc.es, 29-10-10

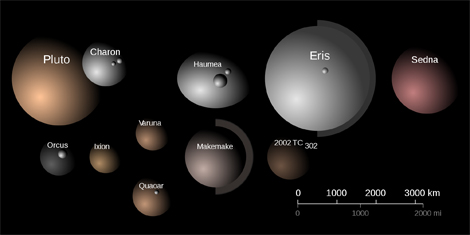

-Mundos oscuros en los confines

del universo

Rebuscando en los archivos de imágenes digitales tomadas por el telescopio

espacial Hubble, un equipo de astrónomos ha detectado recientemente 14 nuevos

vecinos de Plutón. El estudio de tales objetos trans-Neptunianos, oscuros y

helados, sirve para comprender los momentos iniciales de la formación de nuestro

Sistema Solar hace ahora 4.500 millones de años.

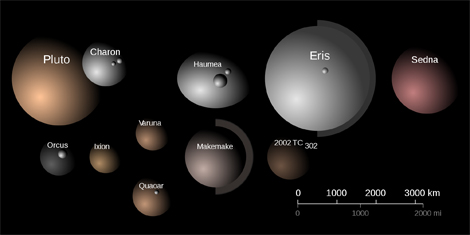

|

Comparación de tamaños y colores de los mayores TNOs | A.

Feild (STScI)

|

Algunos de los mayores TNOs que se conocen | NASA, ESA, A. Feild (STScI |

La región abisal del Sistema Solar

Plutón no es más que uno de los numerosos pequeños mundos que

pueblan la región profunda del Sistema Solar, más allá de la órbita de Neptuno.

Apenas iluminados por el lejano Sol, estos objetos trans-Neptunianos (o TNOs,

por sus siglas en inglés) viven en una permanente oscuridad que dificulta su

localización y su estudio.

Se ha determinado bien la órbita de unos dos centenares de

TNOs, pero de la inmensa mayoría de éstos se conoce muy poco. Plutón, prototipo

de los recientemente denominados 'planetas enanos', es el mayor de todos los

objetos de esa región, desde donde también nos llegan numerosos cometas, como el

Halley.

Auténticas reliquias intactas desde la formación del Sistema

Solar, estos cuerpos conservan la composición química de la nube primordial que

formó nuestro sistema planetario. Su estudio nos permite por tanto ayudar a

comprender los momentos iniciales de la formación del Sol y su grupo de

planetas, hace ahora unos 4.500 millones de años.

Buscando débiles estelas

El inmenso legado del telescopio espacial Hubble, en la forma

de numerosísimas y muy profundas imágenes digitales, se ha revelado como un

poderoso archivo para detectar nuevos ejemplares de estos débiles TNOs. El

astrónomo César Fuentes y sus colaboradores del Harvard-Smithsonian Center for

Astrophysics (cerca de Cambridge, EEUU) han desarrollado una técnica automática

para detectar tales objetos sobre imágenes de archivo. En esas imágenes, un TNO,

debido a su movimiento alrededor del Sol, aparece como una débil estela luminosa

ante las estrellas fijas del fondo.

Los astrónomos desarrollaron un software para localizar tales

estelas de manera automática. La localización de una estela se complementó con

un cuidadoso examen visual que permitió confirmar (o rechazar) la asociación

real de cada estela con un TNO. Tras explorar varios centenares de imágenes de

zonas próximas a la eclíptica (el plano que contiene al Sol y a los ocho

planetas), este equipo de investigadores localizó 14 nuevos TNOs, entre ellos

uno binario (similar al sistema Plutón-Caronte). Todos ellos son oscuros y

extremadamente débiles (más de 100 millones de veces más débiles que las

estrellas visibles por el ojo desnudo).

Las medidas de sus movimientos en el cielo permitieron

calcular las órbitas y distancias de todos los objetos. Y haciendo hipótesis

razonables sobre la reflectividad del material de que están constituidos,

llegaron a determinar los tamaños de todos estos objetos, que resultan estar en

un rango de 40 a 100 kilómetros de diámetro. Todos estos resultados han sido

publicados en un artículo reciente del Astrophysical Journal (Fuente et al.

2010, disponible

aquí.)

Algunos de estos TNOs pueden tener órbitas muy inclinadas

respecto de la eclíptica, por lo que examinando imágenes de regiones más

distantes sería posible detectar aún más TNOs. Los autores esperan extender su

trabajo de esta manera para llegar a detectar quizás varios centenares de nuevos

objetos.

Sin duda el archivo del Hubble nos reserva aún numerosos

descubrimientos y sorpresas.

Nuevos Horizontes

El 19 de Enero de 2006, la NASA lanzó desde Cabo Cañaveral la

sonda New Horizons, una misión no tripulada que tiene por objetivo la

exploración in situ del sistema Plutón-Caronte y de sus dos lunas Nix e Hidra.

La sonda pasó por las proximidades de Júpiter en el primer semestre de 2007 y

allí aprovechó el campo gravitatorio del gigante gaseoso para ganar más

velocidad. Se espera que la sonda sobrevuele Plutón (al que se acercará a una

distancia menor de 10.000 kilómetros) y Caronte en Julio de 2015. También está

previsto que New Horizons pueda explorar otros TNOs antes del año 2020.

También interesante

-

Plutón, descubierto en 1930, fue el primer TNO

identificado. Le siguió su luna Caronte en 1978. Pero fue la detección,

realizada en 1992 desde el observatorio de Mauna Kea en Hawaii, del siguiente

objeto denominado '(15760) 1992 QB1' el que desencadenó las búsquedas

sistemáticas para realizar un censo lo más completo posible.

-

El mayor TNO conocido es Eris, un planeta enano de unos

2500 kilómetros de diámetro, que se encuentra 100 veces más lejos del Sol que

la Tierra (esto es, unas tres veces más lejano del Sol que Plutón). Eris fue

identificado en el año 2005 en el Observatorio de Monte Palomar. Tiene una

pequeña luna (de apenas 100 kilómetros de tamaño) llamada Disnomia (como la

hija de la diosa Eris en la mitología griega).

-

El 31 de Mayo de 2008 se descubrió el primer TNO con

movimiento retrógrado. Se trata del objeto '2008 KV42' apodado informalmente 'Drac'.

-

La sonda New Horizons transporta, además de la carga

científica, un CD con casi medio millón de nombres recogidos en el sitio web

de la misión, una bandera de EEUU y algunas cenizas de Clyde Tombaugh

(1906-1997), el astrónomo estadounidense que descubrió Plutón en 1930.

Fuente: elmundo.es, 28-10-10

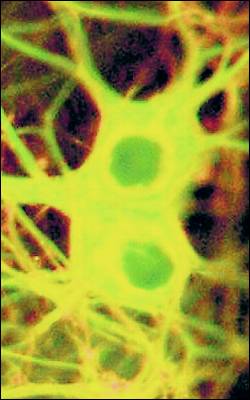

-La ciencia se acerca a la lectura del

pensamiento

|

|

Aunque leer la mente sigue siendo una utopía, es posible

que, en un futuro, se pueda conseguir y, con ello, permitir la

comunicación de pacientes con graves lesiones neurológicas. Un

dispositivo desarrollado por investigadores del Instituto Tecnológico de

California ha sido capaz de registrar la respuesta de las neuronas del

lóbulo temporal medio a distintos estímulos visuales.

De esta forma, los investigadores que publican su hallazgo en la

edición de hoy de Nature son capaces de adivinar

en qué están pensando dentro de las

opciones ofrecidas en el experimento. Para llevar a cabo su

estudio, los científicos, dirigidos por Moran Cerf, aprovecharon los

electrodos implantados en el cerebro de varios pacientes para tratar sus

convulsiones cerebrales y midieron su respuesta ante determinados

conceptos, que incluían desde

personalidades como Madonna a lugares como la torre Eiffel.

Fuente: publico.es, 27-10-10 |

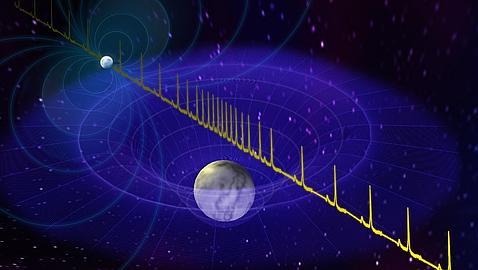

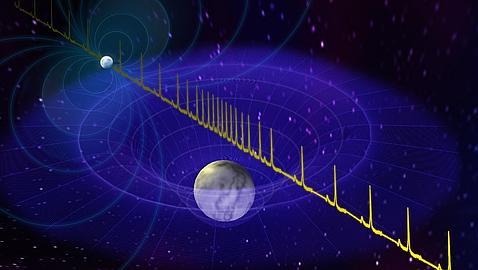

-Hallan la estrella de neutrones

más masiva

Un grupo internacional de astrónomos ha anunciado en Nature

el descubrimiento de la

estrella de neutrones más masiva observada hasta la fecha, un hallazgo que

tendrá importantes repercusiones en diversos campos de la Física y la

Astrofísica. La estrella, un

púlsar que está

a 3.000 años luz de la Tierra y que gira sobre sí mismo 317 veces por

segundo, forma "pareja" con una

enana blanca.

|

|

|

"Esta estrella de neutrones tiene el doble de

la masa del Sol -explica Paul Demorest, del Observatorio Nacional de Radio

Astronomía, (NRAO)- . Lo cual es sorprendente, ya que tanta masa

comprimida en tan poco espacio significa que muchos de los modelos

teóricos que tenemos sobre la composición interna de estrellas de

neutrones quedan descartados. La medida de esta gran masa también tiene

implicaciones en nuestra comprensión sobre la materia cuando se encuentra

en densidades extremadamente altas y

aclara numerosos detalles de la física nuclear".

Una estrella de neutrones es

el cadáver superdenso de una estrella muy masiva que ha estallado en forma

de supernova. Después de la explosión, toda la masa de la estrella

original queda comprimida en

una esfera que mide apenas unos pocos km de diámetro. La fuerza

gravitatoria de este cuerpo superdenso es tal que los electrones, cuya

carga eléctrica es negativa, han terminado por incrustarse "contra natura"

en los protones de los núcleos atómicos (que tienen cargas positivas),

dando como resultado partículas eléctricamente neutras, los neutrones.

|

Una cucharada de cientos de millones de toneladas

Estos neutrones, aplastados unos contra otros por

la gravedad, dan lugar a cuerpos de extraordinaria densidad, las estrellas de

neutrones.

Una simple cucharadita de la materia superdensa de una estrella de neutrones

puede pesar cientos de millones de toneladas. Esta tremenda densidad

hace que las estrellas de neutrones sean extraordinarios laboratorios

naturales para el estudio de los estados más extremos y densos de materia

conocidos por la Física.

Para medir la masa de la estrella, que

prácticamente dobla a la de la mayoría de las estrellas de neutrones

conocidas, los científicos han utilizado un curioso efecto

(el retardo Saphiro) predicho por la teoría General de la Relatividad de

Einstein. La estrella forma parte de un sistema binario, y está acompañada por

una

enana blanca que orbita a su alrededor. La estrella de neutrones, que gira

rápidamente sobre sí misma (317 veces por segundo) es un púlsar que emite, en

cada rotación, potentes ondas de radio.

Este

púlsar, llamado PSR J1614-2230, y su compañera completan una órbita, una

alrededor de la otra, en apenas nueve días. Y resulta que la orientación de

ambas estrellas permite

una excelente observación desde la Tierra, algo de vital importancia

para medir la masa de ambas. Cuando las órbitas llevan a la enana blanca a

colocarse directamente delante del púlsar, las radioondas que emite y que

llegan hasta la Tierra tienen que pasar muy cerca de la enana blanca. Y ese

acercamiento causa un ligero retraso causado por la distorsión gravitatoria de

la enana blanca. Ese ligero retraso, el retardo Saphiro, es precisamente el

que permite medir la masa de ambas estrellas.

"Hemos tenido mucha suerte con este sistema

-afirma Scott Ransom, otro de los investigadores del NRAO-. La rápida rotación

del púlsar nos proporciona una clara señal para seguirlo a través de su

órbita, que está casi perfectamente alineada (con la Tierra). Además, resulta

que la enana blanca es particularmente masiva para una estrella de esa clase.

Y esta combinación única de factores hace que el retardo Saphiro sea mucho más

fuerte y fácil de medir".

Dados sus datos preliminares, los investigadores

pensaban que la estrella de neutrones no tendría más de una vez y media la

masa del Sol. Pero tras observar una rotación completa de ambas estrellas

comprobaron, para su sorpresa, que era de más del doble. Un hecho que, según

ellos, cambia nuestra comprensión tanto sobre la composición de las estrellas

de neutrones como sobre el comportamiento de la materia bajo la presión de

densidades extremas.

Fuente: abc.es, 27-10-10

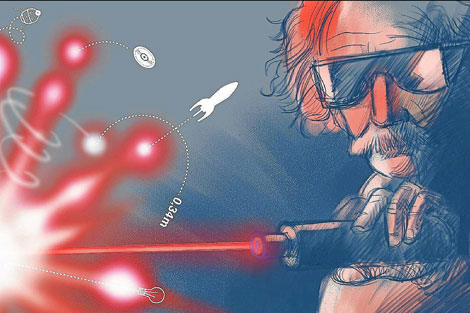

-El rayo que nos cambió la vida

La historia del

láser comenzó en 1917 como un postulado teórico de Albert Einstein, que pensó

que existía la posibilidad de estimular los electrones de un átomo para lograr

que emitieran luz en una determinada longitud de onda. Pero todavía tendría

que pasar algún tiempo para la demostración experimental de este efecto; más

de 40 años para conseguir desarrollar el primer dispositivo eficiente basado

en este enunciado.

|

|

|

A principios de siglo, probablemente, a nadie se le

pasó por la cabeza que la teoría de la radiación estimulada pudiera tener

implicaciones prácticas y, mucho menos, que acabara siendo uno de los

cinco inventos más importantes de la historia. En la actualidad,

es difícil creer que el desarrollo que hace posible el 95% de las

comunicaciones de telefonía se le denominara en los años 50 'un invento en

busca de una aplicación', pero así fue. Y tal vez sea uno de los

mejores ejemplos de cómo una idea surgida de la curiosidad científica

puede transformar radicalmente el mundo.

El interés por desarrollar este artefacto comenzó en

los años 50, una época en la que diferentes grupos de investigadores,

algunos por su cuenta y otros asociados a prestigiosos laboratorios,

perseguían la idea de construir lo que luego sería conocido como láser. Y

aunque, finalmente, fue Mainman el que se llevó 'el gato al agua'

fabricando en 1960 el primer láser experimental que empleaba rubí como

medio amplificador, fueron muchos los científicos que pusieron su granito

de arena para que este invento fuera posible.

Como anécdota curiosa que ejemplifica lo que ha

cambiado la visión de la Ciencia en este medio siglo, se podría contar que

cuando este físico comunicó a la prensa su invención, el dispositivo era

tan minúsculo -sólo medía unos centímetros de longitud- que para la foto

se mostró a los periodistas otro aparato que, aunque no funcionaba,

impresionaba más por su tamaño. |

Alentado por la industria del cine se le atribuyeron

propiedades espectaculares, como la del 'rayo de la muerte', aunque sus

inicios fueron más modestos. De hecho, su primera aplicación

industrial fue la soldadura de chapa de automóviles. Pero a estas

alturas, los investigadores, aún no sabiendo exactamente para qué, ya intuían

sus enormes posibilidades y las patentes relacionadas con este invento se

multiplicaron.

Hoy en día nos sería muy difícil imaginar un mundo sin

láser. Es la base de la fibra óptica que hace posible el funcionamiento de la

red de comunicaciones que ofrece la telefonía o Internet; de soportes como el

CD, el DVD o el Blu ray; del lector de código de barras; de las impresoras

láser; de los hologramas de seguridad en tarjetas de crédito; del desarrollo

de la ingeniería aeronáutica o automovilística; de los bisturís que han

revolucionado la cirugía; del perfeccionamiento de las miras telescópicas; de

los medidores de distancias. En definitiva, si nos detuviéramos a analizar

muchos de los objetos que nos rodean y aplicaciones que nos han cambiado la

vida es seguro que, directa o indirectamente, este invento tiene mucho que

ver.

Pero ¿qué propiedades tiene esta luz que la hace tan

especial? ¿En qué se diferencia de la emitida por otras fuentes, como podría

ser el fuego o una bombilla? Para empezar la palabra 'Laser' son las

siglas inglesas de Light Amplification by Stimulated Emission of Radiation

(Amplificación de Luz por Emisión Estimulada de Radiación) y se trata de una

luz con unas ciertas características bien diferenciadas.

El láser es monocromático, de un solo color,

mientras que la luz ordinaria es el resultado de la combinación de diferentes

colores. Es coherente, lo cual significa que todas sus partículas de

luz están en sintonía con las demás. Y posee también direccionalidad, lo que

implica que sus fotones viajan en la misma dirección, pudiéndose concentrar en

un punto muy pequeño. Y estas propiedades son la base de su inmenso poder y

versatilidad, ya que permiten hacer desde una holografía o cortar un duro

metal a medir la distancia que hay de la tierra a la luna.

El láser del futuro

Este año 2010, el láser cumple medio siglo de vida y

coincidiendo con este aniversario, el Instituto de Física Interdisciplinar y

Sistemas Complejos del IFISC (CSIC-UIB) ha elaborado, dentro de la Semana de

la Ciencia, un programa especial en el que quieren divulgar múltiples aspectos

de este gran invento del siglo XX. El ciclo de conferencias comenzó con la

impartida por Claudio Mirasso, catedrático de la UIB e investigador del IFISC,

titulada 50 años de un invento que ha cambiado nuestras vidas, en la que

explicó los fundamentos científicos del láser, de su tecnología; así como sus

aplicaciones presentes y posibilidades de futuro.

Y si lo que conocemos es sorprendente, lo que está a

punto de llegar entra en el territorio de la ciencia ficción. Según este

investigador no quedan muchos años para lograr la fusión nuclear. La

instalación NIF (National Ignition Facility) es un gran proyecto de EEUU

que posee 192 haces de luz enfocados hacia un punto mínimo. La

focalización de toda esa energía en un diámetro inferior a un cabello

alcanzaría temperaturas de 100 millones de grados -como en el

interior de una estrella- y sería capaz de liberar en la miniexplosión

instantánea una cantidad ingente de energía como para alumbrar a todo un

país. ¿Quién nos dice que no será el láser la fuente de energía inagotable

y limpia que estamos buscando?

Por otra parte, la posibilidad de focalizar el

haz más y mejor está mejorando la capacidad de almacenamiento de la

información. Según Mirasso, la fecha en que podamos tener en un

disco de ordenador todas las películas de la historia del cine en alta

definición está a la vuelta de la esquina. Otro de los campos menos

conocidos del láser es el que está relacionado con la nanotecnología. El

origen de todas estas aplicaciones son las pinzas ópticas conformadas por

un haz de rayo láser fuertemente enfocado, que produce un área de máxima

intensidad y con la energía suficiente para atrapar una partícula de

materia y mantenerla inmóvil en el punto de enfoque de la luz.

Fueron desarrolladas en 1986 por Ashkin y sus colaboradores y, desde

entonces, gracias a la incorporación de diversos tipos de haces de luz se

han perfeccionando, por lo que se cuenta con múltiples técnicas de

manipulación óptica muy avanzadas. Por ejemplo, estas pinzas se han

utilizado para examinar la cantidad de fuerza necesaria para estirar y

enrollar moléculas individuales de ADN. ¿Cómo podríamos denominar a

comienzos del siglo XXI a este 'invento en busca de una aplicación'?

Fuente: elmundo.es, 26-10-10

-Textiles inteligentes integrados en redes inalámbricas

para ocio y salud

Aitex, Ateval y la empresa textil Rapife,

junto con otras entidades, universidades y empresas europeas trabajan en el

desarrollo en nuevos textiles inteligentes aplicados a la medicina, a la

rehabilitación y a los videojuegos dentro del proyecto europeo Wear-a-Ban.

Este proyecto nos sitúa en un nuevo escenario tecnológico relacionado con el

desarrollo textil inteligente que integra sensores, tanto de movimiento como

emocionales, y basados en tecnología de radiofrecuencia, según informa Fedit.

Wear-a-Ban, así se llama este nuevo proyecto europeo cuyo objetivo es

desarrollar redes inalámbricas sofisticadas que integrarán textiles

inteligentes que monitorizarán tanto parámetros físicos (como el

movimiento), como parámetros emocionales.

Se investigarán el potencial de las tecnologías inalámbricas en “redes de

área corporal” que permitan obtener sinergias hombre-máquina en segmentos de

mercado tales como los textiles inteligentes y interactivos, robótica para

asistencia y rehabilitación y dispositivos de interfaz naturales para

videojuegos.

Se busca que la comunicación entre hombre y máquina sea más intuitiva y

natural, integrando la información motora y emocional, parámetros que son

difíciles de expresar con dispositivos estándares. Los recientes avances en

microelectrónica, procesamiento de señales integrados y tecnologías de

software, permiten obtener soluciones hombre-máquina más naturales que

facilitarán nuevas manera de jugar, rehabilitación médica etc.

Fuente:

interempresas.net, 25-10-10

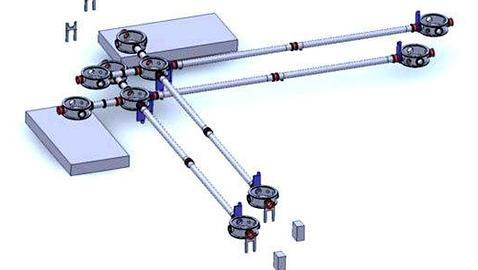

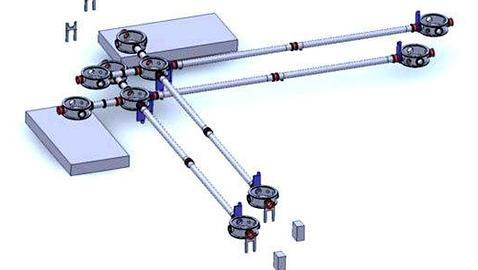

-¿Y si el universo

fuera un hologroma?

Especialistas del

Fermilab -uno de los laboratorios científicos más avanzados y afanados del

mundo- están construyendo un

aparato denominado “Holometer” (u “holómetro”), cuya función será

determinar si el universo tridimensional que perciben nuestros sentidos es “de

verdad” o solo se trata de un holograma. El artefacto busca responder la vieja

cuestión de si el espacio-tiempo es uniforme o discreto.

|

Diseño conceptual del holómetro del Fermilab

|

|

¿Cómo es realmente el universo que percibimos? Esta pregunta aparentemente

inocente ha mantenido a ejércitos de físicos discutiendo durante mucho más

tiempo del que hubiesen preferido. Cuando descubrieron que la energía en

realidad no podía tomar “cualquier” valor, sino que estaba “dosificada” en

pequeñísimos paquetes (llamados cuantos) resultó inevitable preguntarse si

las dimensiones espaciales son realmente tan continuas como nos parecen o

si, por el contrario, también están “pixeladas”.

¿Qué significa esto? Imaginemos que tomamos una cámara fotográfica que

posea una resolución de “infinitos megapíxeles”, y comenzamos a tomar

fotografías de un objeto cualquiera. A “1x” el objeto aparece tal como lo

vemos con nuestros ojos. A “10x” comenzamos a percibir detalles que

difícilmente veríamos a simple vista. A “100x” comienzan a aparecer

detalles imperceptibles de otra manera, que revelan las microrayaduras y

granos de polvo depositados sobre su superficie. Si seguimos aumentando el

detalle de las imágenes, llegará un momento en que podremos “ver” las

moléculas que lo conforman.

Y si seguimos aumentando la resolución de nuestra cámara imaginaria,

veremos sus átomos, y luego sus partículas. Lo que intentan averiguar los

científicos es si esta “realidad”, en alguna escala que somos incapaces de

percibir, comienza a “cuantificarse” tal como se “pixela” una fotografía

al aplicarle un valor de zoom demasiado alto. |

La tercera dimensión

Determinar semejante cosa no es, por supuesto, una tarea sencilla. Los

encargados de tomar el toro por las astas han sido los científicos del

Fermilab, el laboratorio físico nacional estadounidense que posee el segundo

acelerador de partículas más potente del mundo. Una de las teorías que manejan

los especialistas -y que a los profanos nos suena a chino- es que la realidad

consiste solamente en dos dimensiones, y lo que percibimos como una “tercera

dimensión” no es otra cosa que una “ilusión” -sumamente realista, por

supuesto- que surge de la interacción de estas dos con el tiempo.

Si esto es cierto,

la realidad sería algo así como un holograma, una especie de truco de mago de

feria en el que se nos “vende” una dimensión que realmente no está

allí. Algunos físicos creen que no podemos darnos cuenta del engaño “culpa” de

algunas limitaciones impuestas por las leyes de la física, como que “nada

puede viajar más rápido que la luz” y naderías por el estilo. No sabemos cómo

se podría conciliar todo esto con las 10 dimensiones contempladas por

la Teoría de Cuerdas y

los universos paralelos que buscan con el LHC, pero seguramente ambas

hipótesis no puedan ser válidas a la vez.

En el Fermilab han comenzado la construcción de un holómetro (“holometer”) ,

un máquina de altísima tecnología que podría atisbar por los “espacios”

existentes entre uno y otro “píxel” de la realidad. Explicar cómo funciona una

máquina como esa es sumamente complicado, pero en un comunicado del

laboratorio han dejado entrever que hará su magia gracias a

un reloj extremadamente preciso (en realidad, será

el más exacto jamás construido) y un láser. Los primeros datos serán

proporcionados por el holómetro en algún momento del año próximo. Si recuerdas

la película

«Matrix», esto significa que tienes entre 3 y 12 meses para decidir si

tomas la pastilla roja o la pastilla azul.

Fuente: abc.es,

25-10-10

-Vegetación autóctona clave para recuperar territorios contaminados

Un grupo de

investigadores perteneciente a la Unidad de Botánica del Departamento de

Biología de la UAM, y dirigido por la Dra. Vicenta de la Fuente, estudia las

dinámicas de vegetación y las modificaciones en los suelos de uno de los

territorios más ácidos y con mayor contenido en metales de la Península: la

cuenca del Río Tinto (Huelva).

En un trabajo publicado recientemente en Arid Land Research and Management, los

investigadores presentan un compendio de la vegetación autóctona de la cuenca

del Río Tinto y de las dinámicas temporales regresivas y progresivas de la

misma. En el trabajo se muestra que la evolución progresiva (desde las

comunidades de vegetación colonizadora de suelos pobres y terrenos desnudos

hasta alcanzar la fase madura del bosque) implica un enriquecimiento en especies

autóctonas y un cambio gradual en los suelos, donde disminuye la acidez y se

tiende a reducir la concentración de alguno de los elementos predominantes del

territorio (S, Fe, As y Pb).

Estos resultados constituyen una clave de vital importancia a la hora de

plantear programas de restauración de territorios contaminados con metales

pesados. El empleo de la vegetación autóctona, respetando la secuencia de la

serie de vegetación del territorio afectado, garantiza una reforestación

efectiva (aunque lenta), contribuye a la protección de la flora y vegetación

autóctona, favorece el enriquecimiento progresivo de la biodiversidad vegetal,

modifica el paisaje y evita pérdidas económicas por la muerte de especies

alóctonas no aclimatadas.

Dinámicas de vegetaciones y suelo

Desde el punto de vista climático, edáfico y biogeográfico, la vegetación de un

territorio homogéneo evoluciona temporalmente hasta alcanzar lo que se considera

la comunidad vegetal clímax o permanente, que generalmente suele ser un bosque.

Partiendo de una roca desnuda, el esquema teórico que seguiría la vegetación

hasta alcanzar la comunidad clímax sería: comunidades vegetales pioneras,

pastos, matorrales, pre-bosques y bosques. El conjunto de todas estas

comunidades constituiría lo que se denomina serie de vegetación. El cambio

sucesivo de las comunidades vegetales que componen la serie de vegetación

conlleva una evolución en los suelos sobre los que se asienta desde el punto de

vista físico y químico.

Río Tinto

El río nace en el corazón de la comarca minera del Andévalo, situada sobre uno

de los depósitos de sulfuros metálicos más extensos del mundo. En este ambiente

dominan el ácido sulfúrico, el hierro férrico y numerosos metales que se

encuentran químicamente biodisponibles en concentraciones tóxicas dada la

elevada acidez de las aguas y los suelos del territorio. Además, la histórica e

intensa actividad minera en la comarca, tanto a cielo abierto como subterránea,

ha provocado la pérdida de suelos y por ende la eliminación de la cubierta

vegetal, quedando una gran extensión de terreno desnudo, taludes, desmontes y

escombreras.

Fuente: UAM,

24-10-10

-Bienvenidos a la segunda era espacial

Los catalanes Ana Bru y Ramón Segarra se vieron ya vestidos

de astronautas. Pepita Campdesuñer, la empresaria jubilada de 80 años, empezó a

contar los días para su primer vuelo a la heterosfera. Y Richard Branson,

el visionario fundador de Virgin Galactic, oteó con impaciencia los

cielos moteados de Nuevo México, invocando la silueta etérea de su nave

suborbital.

|

"Bienvenidos a la segunda era espacial", proclamó Branson,

mientras anticipaba el vuelo rasante de WhiteKnightTwo, la nave

nodriza, arropada en el aire por la trepidante SpaceShipTwo (capaz

de subir por encima de los 100 kilómetros de altitud propulsada por un

cohete híbrido).

"Entre ocho y 19 meses acabaremos con la fase de pruebas

y estaremos listos para los primeros vuelos comerciales", vaticinó el

magnate de Virgin, con su inconfudible melena rubia, sin quitarse la chupa

de cuero. "La seguridad es nuestra prioridad absoluta: los turistas

espaciales han comprado un billete de vuelta".

Hasta la fecha, un total 370 mortales que están

dispuestos a pagar 144.000 euros por dos horas y media de vuelo. Setenta de

ellos se desplazaron este fin de semana hasta el Spaceport de Nuevo México,

a tomarle la medida a la primera pista 'espacial' de tres kilómetros de

largo por 61 metros de ancho.

La mayoría esperaba ver poco más que una

serpiente de asfalto en mitad del desierto. Los primeros

sorprendidos fueron Ana Bru y Ramón Segarra, que decidieron ponerse el casco

de obras e inspeccionar el impresionante aeropuerto/hangar diseñado por

Norman Foster, emergiendo ya con su perfil de molusco futurista sobre la

arena.

'Quisimos ser los primeros en probar'

"Nosotros siempre tuvimos fe en este proyecto, aunque

para muchos era difícil de imaginar", confesaba la pareja de 'pioneros'

catalanes, que reclutan aspirantes españoles a través de la agencia Bru&Bru.

"Quisimos ser los primeros en probar y la verdad es que hoy

lo hemos visto más claro que nunca. Ahora que el futuro está tan cercano,

sentimos mucha emoción y un cierto cosquilleo". |

|

Aeropuerto espacial de Nuevo México |

El WhiteKnightTwo sobrevoló varias veces su futuro nido,

antes de aterrizar en la pista recién inaugurada, en medio de un

paisaje sideral y a más de 20 kilómetros de la población más

cercana (llamada curiosamente 'Verdad y Consecuencias', en homenaje a un

legendario programa televisivo).

"Dejamos atrás 52 años de historia y entramos

decididamente en una nueva era", certificó la administradora adjunta de la

NASA Lori Garver a pie de pista. "Atrás queda lo que llamábamos la

'carrera' espacial. Ahora avanzamos por el camino de la cooperación

entre países y entre empresas. Estamos todos en la misma nave".

Richard Branson se subió sobre la marcha y anunció que

Virgin Galactic pujará –en solitario o junto a otras dos compañías- al

programa de 50 millones de dólares para desarrollar futuras naves

tripuladas auspiciado por la Administración Obama. "Tenemos planes

para explorar el campo de los vuelos orbitales en los próximos años",

anticipó.

De momento, Branson se ha reservado el primer vuelo

para toda la familia (incluidos su hijo Sam y sus padres de 92 y

89 años) y confía en despegar del Spaceport de Nuevo México a

finales del 2011 o primeros del 2012. "Para mí, este viaje es algo muy

presonal", recalcó. "Aunque mi empeño será hacer el turismo espacial

accesible para el común de la gente. Cuando llevemos quinientos o mil

pasajeros podremos bajar las tarifas, y, tal vez, fletar tres vuelos

diarios. Espero que los vuelos suborbitales sean algo 'normal' para

vuestros hijos y vuestros nietos".

"¿Para cuándo un Aeropuerto Espacial en Europa?", le

preguntamos. "Tenemos que consolidar primero este proyecto antes de

pensar en futuras ubicaciones". ¿España está en el radar? "Amo

mucho a España y puedo asegurar que cuando llegue el momento

estará muy alto en la lista".

"Lo primero es estabilizar este proyecto aquí, y

después lo llevaremos a España", declaró en español y con cierta sorna

el gobernador Bill Richardson, que decidió impulsar el proyecto

(estimado inicialmente en 212 millones de dólares) para convertir

Nuevo México en el centro de gravedad del turismo espacial.

Más que la experiencia de la ingravidez, Ana Bru espera

disfrutar de la "pura adrenalina" de la subida y, sobre todo, de la

experiencia de la bajada. "Ahí es cuando de verdad sientes donde

tienes el estómago", asegura, recordando el entrenamiento en el

simulador del Nastar Space Center de Filadelfia. Ramón Segarra recuerda la

sensación de otra manera –"es como si te estiraran la piel"- pero insiste en

que los vuelos suborbitales son aptos "para cualquier persona con buena

salud".

"Nosotros no somos multimillonarios, ni coleccionamos

coches en el garaje como Bill Gates", asegura Ana. "Hemos ido

reservando el dinero durante bastante tiempo porque sabemos que

ésta puede ser la gran experiencia de nuestras vidas. Yo siento una tremenda

curiosidad por ver y apreciar la Tierra desde allí arriba".

"Volando me siento insignificante, como si estuviera

conectada con la naturaleza", confiesa por su parte la octogenaria y

vitalísima Pepita Campdesuñer, superada tan sólo en edad por los padres del

propio Branson. "Yo tomé uno de los primeros vuelos comerciales en un

trimotor en 1953, entre Bilbao, Barcelona y Palma. Recuerdo también como si

fuera ayer el momento en que el hombre puso el pie en la Luna. Y quiero

vivir desde dentro este otro momento histórico... A ver si me llega".

Fuente: elmundo.es, 23-10-10

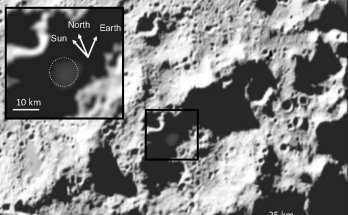

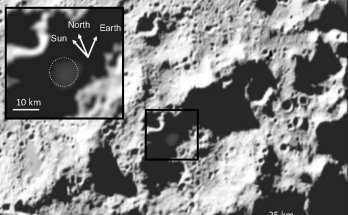

-La NASA descubre plata en la cara oculta de la Luna

|

El impacto sobre la superficie lunar, provocado por

un cohete de la NASA en octubre del año pasado, ha revelado que,

bajo la superficie del cráter Cabeus, en el polo sur, hay un

5,6% de agua helada, y también otros elementos como hidróxido,

monóxido de carbono, amoníaco, mercurio, magnesio, sodio y hasta la

preciada plata.

La NASA lanzó el Satélite de Observación del Cráter

Lunar, conocida como misión

LCROSS, el 18 de junio del año pasado. Llevaba a bordo un cohete, el

Centauro, que tres meses y medio después, el 9 de octubre, se estrellaba

contra la Luna, generando una gran nube de más de más de 750

metros sde altura obre su superficie. Según el artículo que se

publica en 'Science', se estima que fueron expulsados hacia el espacio

entre 4.000 y 6.000 kilos de restos y vapor de agua.

A los cuatro minutos de la explosión, la sonda LCROSS

atravesaba esa nube para recoger muestras, que durante un año han sido

analizadas por varios grupos de investigación en Estados Unidos.

Los resultados del equipo de Anthony Colapetre, del

Centro de Investigación Ames de la NASA, revelan que el impacto expulsó

unos 155 kilos de vapor de agua y hielo, y estiman que un 5,6% de la

masa total del interior del cráter Cabeus es agua helada. También

encontraron hidrocarburos, sulfuro y dióxido de carbono. |

|

|

Geología compleja

En la

Universidad de

Brown, otro equipo, dirigido por el geólogo Peter Schultz, ha analizado

las características del cráter y los minerales que contiene, encontrando que

la composición de la Luna es mucho más compleja de lo que se pensaba. Además

de agua, también contiene compuestos como el amoniaco, el sodio y la

plata.

Todos estos elementos combinados, les han dado pistas

sobre el origen de estos minerales y el proceso por el cual acabaron los

cráteres polares, que no han visto la luz del Sol en miles de millones de

años.

Schultz cree que los elementos detectados llegaron a la

Luna por impactos de cometas, asteroides y meteoritos a lo

largo de su historia. Apunta que se fueron depositando por todas las parte

del satélite terrestre, pero que después fueron liberados de la superficie

por otros impactos menores o se calentaron con el Sol, lo que les dio

energía suficiente para volar hasta alcanzar los polos, donde habrían

quedado atrapados entre las sombras de los cráteres.

Además, mantiene la hipótesis de que la variedad de

elementos volátiles implica que hay una especie de guerra constante

entre lo que se acumula y lo que se pierde continuamente en la tenue

atmósfera lunar. "Hay un equilibrio entre lo que llega y lo que se

va, aunque creo que va ganando lo que está llegando", afirma el experto, que

ha estado estudiando la Luna desde los años 60.

Fuente: elmundo.es, 22-10-10

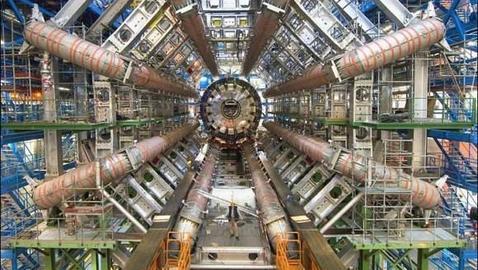

-El

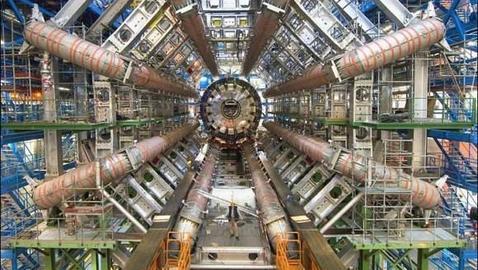

LHC busca universos paralelos

|

El gigantesco

acelerador de partículas

LHC, construido por el

CERN, podría encontrar dentro de poco tiempo evidencias de la

existencia de “universos paralelos”. Suena a ciencia ficción, pero parece

que los experimentos de física de alta energía que se realizan en ese

lugar podrían efectivamente probar la validez de estas teorías. Mientras

tanto, seguimos esperando la “aparición” del escurridizo

bosón de Higgs.

Es muy difícil hablar de “universos

paralelos” sin pensar en el argumento de una historia de ciencia

ficción. Sin embargo, y aunque la idea ha sido difundida ampliamente por

los escritores de este tipo de novelas, el concepto tiene muchos adeptos

entre los científicos. Desde el punto de vista de la ciencia, tal como

lo explica el último boletín de noticias emitido por el

CERN, referirse a los universos paralelos significa hablar de

“formas desconocidas de materias o dimensiones extras”. Desde hace

décadas, los físicos se han quemado las pestañas tratando de determinar

si el universo realmente posee las cuatro dimensiones de toda la vida

(tres físicas y una temporal), o si existen otras que por su naturaleza

no podemos percibir.

|

|

|

La

Teoría de Cuerdas, por ejemplo, postula que las partículas de nuestro

universo, como los electrones o protones, no son un mero "punto sin estructura

interna y de dimensión cero”, sino una minúscula cuerda que vibra en un

espacio-tiempo de más de cuatro dimensiones. Sus defensores creen que estas

cuerdas no se mueven en el espacio-tiempo ordinario de cuatro dimensiones

(tipo Kaluza-Klein) sino que lo hacen en seis dimensiones adicionales,

compactadas, dando lugar a un universo de 10 dimensiones: una temporal, tres

espaciales “normales” y seis “minimizadas” e indetectables por ahora.

Dimensiones ocultas

Los físicos del CERN que investigan los orígenes

del Universo esperan que en 2011 puedan obtenerse, gracias al LHC, las

primeras pruebas concretas de estas “dimensiones ocultas”. Esto no significa

que se hayan abandonado los esfuerzos dedicados a dar con el bosón de Higgs -a

veces referido como

“la partícula de Dios” por la prensa- ni mucho menos. De hecho, estas

dimensiones extrañas del universo podrían evidenciarse mientras se producen

los choques de partículas de alta energía que el acelerador provoca para

encontrar la escurridiza súper partícula.

El director general del CERN, Rolf Heuer, tiene

la esperanza de que al analizar los datos generados por el acelerador aparezca

alguna evidencia de estos -quizás mal llamados- “universos paralelos”. El

mismo Heuer ha dicho que el acelerador está produciendo

choques de protones a un ritmo de 5 millones por segundo, algunas semanas

antes de lo que estaba previsto. Si no surgen retrasos, a principios

del próximo año este ritmo se incrementará, y los detectores del CERN entregarán

miles de millones de datos extra entre los que se podrían encontrar

“algunas sorpresas”.

Aparece y desaparece

¿Como podemos saber que una de estas dimensiones

ocultas existe realmente? Los físicos del CERN creen que al analizar los datos

del acelerador podrían encontrar rastros

de que alguna partícula “desaparece” durante un brevísimo lapso de tiempo,

para luego aparecer nuevamente. Si ello ocurre, una de las

explicaciones posibles sería que la partícula en cuestión se ha “deslizado” a

alguna de estas seis dimensiones ocultas para luego volver al universo que

todos conocemos. Esto, de producirse y probarse su existencia, no significa

que tengamos -ni remotamente- la posibilidad de explorar o viajar a estos

“universos paralelos”. Solo habríamos probado que la estructura íntima de la

materia es diferente a lo normalmente aceptado, que -por supuesto- no es poca

cosa.

Fuente: abc.es, 22-10-10

"Esto

puede ser muy parecido a `Gran Hermano´"

El viaje imaginario a Marte más ambicioso de la historia

lleva más de 140 días en marcha. Sus participantes tres rusos, un francés, un

italocolombiano y un chino no se han movido ni un centímetro del módulo de

aislamiento en Moscú en el que simulan un viaje de ida y vuelta al planeta

rojo. Por delante quedan más de 350 días en los que seguirán siendo objeto de

decenas de experimentos y durante los cuales se enfundarán en trajes

espaciales para explorar una superficie marciana de pega. Diego Urbina, uno de

los tripulantes de la misión Mars 500, financiada por la Agencia Espacial

Europea y el Instituto de Problemas Biomédicos de Moscú, narra su experiencia

a Público con un sistema de email con retardo, debido a que, en

teoría, está a más de 33 millones de kilómetros de la Tierra.

¿En qué punto se encuentran y cuándo llegarán a

Marte?

Desde aquí la Tierra sería como una moneda de dos euros a

una distancia de 70 metros. Llegaremos a Marte en febrero de 2011. Entonces,

Alexander, Wang Yue y yo nos iremos a vivir al módulo de aterrizaje marciano

durante un mes y realizaremos una exploración con trajes de astronauta.

¿Cómo es un día normal dentro del módulo de

confinamiento?

Nos levantamos a las ocho de la mañana y nos entregamos a

las tareas rutinarias, tests psicológicos, muestras de orina... Después

desayunamos juntos. Antes nos lavamos las manos, claro. Hacemos experimentos y

luego vamos al gimnasio durante una hora. Luego comemos y hacemos más

experimentos. Tenemos casi toda la tarde libre. La pasamos leyendo, viendo

películas o jugando a videojuegos con la red interna de la nave. En total

tenemos unas seis horas de trabajo al día, diez horas libres y otras ocho para

dormir. Algunos días sientes que necesitas más trabajo, aunque a finales de

mes, cuando se concentra la mayoría de los experimentos, esto es una locura.

Están realizando más de 100 experimentos, desde

usar medicina alternativa a aliviar la tensión con realidad virtual. ¿Cuáles

han sido los más difíciles?

Mis experimentos favoritos son los simuladores con naves

espaciales y los que tienen ejercicio físico, aunque el que más aborrezco es

uno en el que tengo que sostener una bolsa de 25 kilos durante un buen rato.

Otro que no es nada divertido es pincharme el dedo cada hora durante una

mañana entera para tomar muestras de sangre, aunque afortunadamente sólo lo

tenemos que hacer cada dos meses.

Ahora que lleva 140 días, ¿qué cree que sería

diferente si realmente estuviera viajando hacia Marte?

Muchas cosas serían igual. La separación de tu familia, la

soledad, la autonomía, la necesidad de vivir una vida nueva mucho más simple,

el extraordinario cuidado que debes tener contigo mismo, la necesidad de que

el equipo funcione, la paciencia y testarudez que se necesita para hacer algo

como esto... Pero otras cosas cambiarían, como la posibilidad de sufrir

accidentes con la nave o lo emocionante que sería llegar a Marte de verdad.

¿Qué ha sido lo mejor de estos 140 días?

He tenido muchas experiencias positivas, sobre todo cuando

intentas sobreponerte a las dificultades con cierta ingenuidad. Por ejemplo,

me he inventado una manera para poder twittear de forma indirecta,

sin internet. También he ideado un software que me ahorra tener que repetir

muchos experimentos. Hasta he diseñado una especie de bolsillo extra para los

pantalones cortos reglamentarios, que por un error se hicieron sin bolsillos.

Todo esto parecerá una tontería desde fuera, pero aquí te ayuda a seguir

adelante, a aprender de ti mismo y conocerte mejor.

¿Qué ha sido lo peor?

Por ahora no me puedo quejar, toco madera. Tal vez lo peor

sea no poder hablar italiano o español casi nunca.

¿Qué dice su familia sobre lo que está haciendo?

Me animan mucho. Me mandan noticias de todo el mundo. No

podría hacer lo que hago sin el apoyo que me están dando.

Su misión se ha rebautizado como el Gran Hermano

Marciano'. ¿Está empezando a parecerse?

Puede ser muy parecido, porque tenemos a un grupo de gente

que vive en el mismo sitio y está siendo grabada en todo momento. El resto es

diferente, aquí la gente no finge, ni se pelea ni hace cosas intolerables para

ganar audiencia o ser más popular. Aquí sólo somos seis tipos intentando hacer

cada día lo más agradable posible, mientras hacemos un trabajo duro.

¿Qué es lo que más echa de menos? ¿Tal vez a su

pareja?

La libertad de poder ir a donde quiera. La facilidad de

comunicarme con quien quiera por teléfono o internet. Echo de menos a mi

familia y amigos. Sin embargo, estar aislado de posibles distracciones tiene

ventajas, más oportunidades para mejorar como persona.

¿Cómo está la moral para llegar a los 520 días?

Estupenda. Pasamos mucho tiempo juntos y estamos de buen humor. Esperamos

que todo siga así en la segunda parte de la misión.

¿A qué piensa dedicarse una vez termine la misión?

Seguiré siendo ingeniero espacial y me dedicaré a la educación para

contribuir a que algún día la humanidad salga de su cuna, la Tierra.

¿Qué será lo primero que haga cuando salga de ahí?

Me pegaré una cena impresionante y me iré a bailar música latina hasta que

me caiga redondo.

Fuente: publico.es, 21-10-10

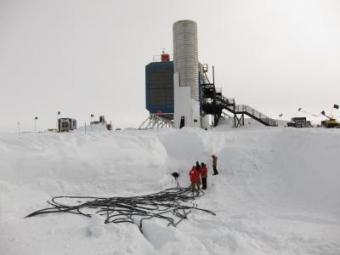

-La

sonda LCROSS confirma la presencia de agua helada en la Luna

Cinco toneladas de Luna que

habían estado esperando miles de millones de años en un oscuro cráter

salieron a la luz cuando

una sonda de la NASA se estrelló allí el 9 de octubre del

año pasado. El análisis del material liberado, presentado ayer en rueda de

prensa y detallado hoy en la revista Science, confirma que los cráteres del polo

sur de la Luna albergan una gran cantidad de agua helada.

|

El cráter Cabeus, lugar del impacto de la sonda

Lcross de la NASA en el polo sur de la Luna NASA

|

|

Estos resultados “indican que hay minerales de interés a

poca profundidad y que se podrá acceder a ellos con las tecnologías

actuales” si se envía una misión robótica o tripulada al polo sur de la

Luna, explicó ayer Ignasi Casanova, geólogo planetario de la Universitat

Politècnica de Catalunya que trabaja en un proyecto de exploración lunar.

Cuando

la NASA lanzó la

misión LCROSS en junio del 2009, el

objetivo era precisamente explorar la superficie lunar con vistas a volver a

enviar astronautas allí alrededor del 2020 y más adelante construir una base

lunar. En este sentido, la misión ha cumplido sus objetivos. Desde el punto

de vista de ingeniería, sus resultados allanan el trabajo a futuras

misiones, apunta Casanova.

En los últimos 16 meses, sin embargo, la Administración Obama ha reorientado

la estrategia de la NASA y ha renunciado a los planes de reanudar los vuelos

tripulados a la Luna. En este nuevo contexto, no hay planes para que los

frutos de LCROSS tengan continuidad a corto plazo.

Según los resultados presentados ayer, el impacto que la misión LCROSS

provocó en el polo sur de la Luna abrió un cráter de entre 25 y 30 metros de

diámetro. Con el calor liberado en la colisión, los minerales que se

encontraban allí pasaron de unos 230 grados bajo cero a más de 700 grados.

El impacto liberó por lo menos dos toneladas de minerales, y probablemente

entre cuatro y seis, que salieron despedidas hacia el espacio formando un

gran penacho de gas y polvo. |

Los investigadores han estimado que cerca de un 5,6% del material liberado era

vapor de agua, una cantidad suficiente para pensar en extraer oxígeno del suelo

del satélite el día que los astronautas vuelvan a la Luna. El director

científico de la misión, Anthony Colaprete, calcula que hay suficiente agua para

llenar 1.500 piscinas olímpicas en el cráter Cabeus, una

formación de unos 100 kilómetros de diámetro que fue elegida para el impacto.

Cabeus fue seleccionado porque tiene una amplia región en la que nunca brilla el

sol. Al estar siempre a baja temperatura, pensaban los científicos, habría

conservado el agua helada de los cometas que han caído allí desde los albores

del sistema solar. Los resultados presentados ayer han superado las

expectativas, ya que el cráter contiene más agua de la que se esperaba.

Junto al agua, los investigadores han identificado otras moléculas interesantes

como hidrocarburos ligeros, así como metales inesperados como plata y mercurio.

“Los hidrocarburos son interesantes cara a comprender cómo llegaron estos

minerales a la Luna”, explicó ayer Ignasi Casanova. En cuanto al mercurio, del

que se liberaron 120 kilos en el lugar del impacto, habrá que tomar precauciones

para evitar que intoxique a astronautas en el futuro, advirtió Kurt Retherford,

investigador de la misión.

Fuente: lavanguardia.es, 21-10-10

-La ONU pesimita con

respecto a los acuerdos de Cancún

La ONU ha descartado que la

Conferencia de las Partes de

Naciones Unidas sobre Cambio Climático (COP16) que se celebrará a finales de

año en Cancún alcance "acuerdos exhaustivos", pero confió en que se logren

pactos "integrales con resultados a corto plazo".

Así lo afirmó en la capital mexicana Christiana Figueres,

principal representante de la

ONU para el diálogo sobre el cambio climático, quien aseguró que durante la

cita de Cancún se requerirá una "voluntad política decidida"

para lograr acciones concretas.

La alta funcionaria señaló, a través de una videoconferencia

durante un seminario sobre cambio climático organizado por la ONU, que los

gobiernos que asistirán a Cancún "quieren abordar todos los temas, pero

será imposible hacerlo en detalle".

Acuerdos y desencuentros

En su opinión, uno de los asuntos más complejos en la

negociación será el de lograr metas en la reducción de emisiones de dióxido de

carbono y definir qué países deben adoptar estas limitaciones. Sin embargo,

señaló que existe un consenso sobre la necesidad de crear un fondo

para que los países desarrollados apoyen la reducción y adaptación al cambio

climático de las naciones en desarrollo.

Otro de los puntos en los que se podrían avanzar

acuerdos, según Figueres, es la reducción de la deforestación a través del

Mecanismo

de Reducción de Emisiones por Deforestación y Degradación de los Bosques (REDD+).

La funcionaria afirmó que en Cancún podrían darse las condiciones para

otorgar incentivos a los países que reglamenten la deforestación. Sobre la

aprobación de una nueva "arquitectura financiera" las naciones están

divididas entre los que quieren que se apoyen en instituciones existentes

como el

Banco Mundial,

y los que defienden la creación de un fondo nuevo controlado por los

gobiernos, dijo Figueres.

Se refirió también a la confrontación entre China

y Estados Unidos, los dos países con mayores emisiones

contaminantes del mundo y que no están sometidos a compromisos de reducción.

A su juicio, la Cumbre de Cancún debería lograr que ambas naciones firmen

sus promesas, hasta ahora "informales", de reducción de emisiones.

Futuro incierto

Figueres aseguró que es una incógnita qué sucederá con el

Protocolo de Kioto, que vence en 2012, pues la mayoría de países en

desarrollo apuestan por un nuevo periodo de compromiso a partir de 2013 y

otros, como Rusia y Japón, se oponen a ello. Este lunes, el Gobierno de

México, anfitrión del encuentro de Cancún, reconoció también que "no están

dadas las condiciones" para lograr un acuerdo global de reducciones de

emisiones de gases en esa cita.

Según Figueres, la COP15, celebrada el pasado año en

Copenhague y que concluyó sin un acuerdo vinculante en reducción de

emisiones, estuvo marcada por la falta de transparencia, mientras que para

la COP16 el gobierno mexicano actúa bajo la premisa de la "inclusividad".

Las autoridades mexicanas calculan que más de 30.000

personas asistirán cada día a la cita de Cancún, a la que de momento ningún

mandatario ha confirmado su participación pero en la que estarán

representadas 193 naciones.

Fuente: elmundo.es, 20-10-10

-La nueva "arca de Noé" es una torre de 100 metros

Un

zoológico vertical de más de 100 metros ha sido propuesto para ser

construido en Buenos Aires, en la Reserva Ecológica Costanera Sur. El

proyecto, denominado

Eco-Cliff, consiste en una espectacular torre que podría servir como

punto de anidación para miles de aves migratorias y un hábitat ecológico para

todo tipo de animales.

|

|

Una de las estructuras conceptuales más

interesantes presentadas en los últimos tiempos ha sido la torre de

burbujas del MIT, que estaba planeada para las Olimpiadas de 2012 en

Londres. Sin embargo, ahora estamos frente a un concepto aún más

interesante, que podría construirse en Argentina. La torre ha sido

diseñada por Hila Davidpu, Tal Gazit, Eli Gotman y Hofi Harari para

participar de una competición para construir un

zoológico vertical frente a Puerto Madero, en la Reserva Ecológica

Costanera Sur.

Sería un verdadero

espectáculo para la vista si se hiciera realidad. Según explican los

responsables, para minimizar el uso de vehículos a motor, la torre

solo sería accesible mediante teleférico y utilizaría un sistema de

células fotoeléctricas para autoabastecerse de energía. Y no solo sería un

impactante diseño, sino que también sería un zoológico y hábitat para varios

tipos de animales.

Todos los visitantes podrían ver a los animales a través de senderos

artificiales que serpentearían a lo largo de la torre, ofreciendo una

experiencia fuera de lo común. Con la idea de simular un acantilado, la torre

tendría varias aperturas para que ingresen los rayos del sol, la lluvia y el

aire fresco, y se serviría de un sistema de redes y cables para cumplir

distintas funciones. La pregunta que quedaría por responder es si muchas

especies animales serían capaces de vivir en una torre de más de 100 metros del

altura, en condiciones que, sin más detalle, parecen distar bastante de las de

su hábitat natural. Si llegan a hacerlo posible, sería una cita obligada como

muchas otras fantásticas construcciones alrededor del mundo.

|

Fuente: abc.es,

19-10-10

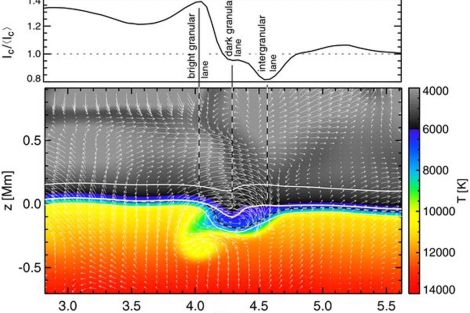

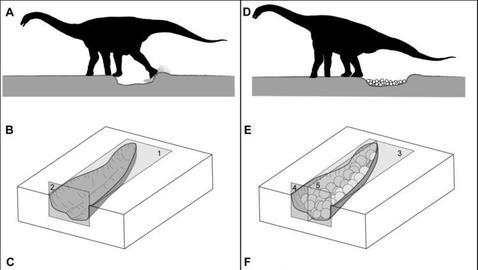

-El

canibalismo del "Tiranosaurio rex"

El rey de los dinosaurios practicaba el canibalismo. El

temido 'Tiranosaurio rex' no sólo comía otros dinosaurios sino que también se

alimentaba de ejemplares de su misma especie. Un grupo de paleontólogos de EEUU

y Canadá ha llegado a esta conclusión tras comprobar que las mordeduras halladas

en algunos huesos gigantes fueron hechas por un 'Tiranosaurio rex'. La

investigación ha sido publicada esta semana en la revista

PLoS ONE.

El cine ha hecho del 'T. rex' uno de los dinosaurios más

conocidos. Fue también uno de los carnívoros terrestres de mayor tamaño

de todos los tiempos: podía alcanzar los 13 metros de longitud y medir cinco

metros de altura. Asimismo, su peso podía llegar a las 10 toneladas.

Este animal vivió hace entre 67 y 65 millones de años en el Maastrichtiano, la

última época del Cretácico, en el territorio que hoy ocupa Norteamérica.

Su dieta es uno de los aspectos que más discusión

siguen suscitando entre los científicos ya que, hasta ahora, había

pocas pruebas directas sobre la forma en la que se alimentaba.

Una práctica habitual

|

Recreación de un T. rex devorando a otro. | N. Longrich /

Yale University

|

|

Tras examinar las colecciones de fósiles de varios

museos, el equipo liderado por el investigador de la

Universidad de Yale Nick

Longrich halló en cuatro ejemplares de 'T. rex' marcas de dientes realizadas

por dinosaurios carnívoros de gran tamaño. La mayor parte de las mordeduras

estaban en las patas. El único animal capaz de hacer este tipo de marcas en

la época en la que vivieron los animales examinados era otro 'T. rex'.

Los investigadores se han mostrado sorprendidos por la

frecuencia con la que aparentemente practicaban el canibalismo, aunque

todavía no saben su significado. Es posible que actuaran

como carroñeros cuando un animal moría o bien el resultado de una pelea

entre 'T. rex': el ganador se daba un festín a costa del derrotado.

"Los carnívoros actuales se comportan así todo el tiempo. Era una

manera de acabar con la competencia y obtener comida al mismo tiempo",

asegura Longrich.

Sin embargo, algunas de las marcas fueron hechas

tiempo después de que el animal hubiera fallecido. Según los

investigadores, esto podría explicarse de la siguiente manera. El dinosaurio

vencedor se habría comido las partes más accesibles de su víctima en el

momento de la muerte. Tiempo después, habría vuelto a por los huesos de las

patas.

|

A pesar de que a los científicos sólo les consta que otra

especie de dinosaurio, el 'Majungatholus', practicara el canibalismo, los

paleontólogos sospechan que se trataba de una práctica relativamente común

entre los grandes carnívoros.

Fuente:

elmundo.es, 19-10-10

-Cazando leones en Atapuerca

Efectivamente, el nivel 10 de este yacimiento está siendo excavado desde el

año 1980, primero en una reducida extensión y desde hace más de 10 años en una

área de aproximadamente 80 metros cuadrados. Se han registrado decenas de miles

de restos esqueléticos pertenecientes básicamente a herbívoros, así como

herramientas de piedra talladas sobre rocas de silex y cuarcita, pertenecientes

presumiblemente a los restos dejados por el

Homo

heildebergensis en sus ocupaciones humanas en esta cueva durante el

Pleistoceno medio, hace entre 300.000 a 350.000 años.

El análisis efectuado sobre los restos óseos de un paleodepredador de gran

tamaño podría alcanzar los 400 kilos; se ha podido demostrar que se habían

practicado sobre su cadáver una serie de intervenciones destinadas a la

obtención de la biomasa animal. Había sido despellejado y eviscerado,

siguiendo las pautas que los homininos hacían servir en el Pleistoceno con otros

vertebrados herbívoros.

La caza de un león de gran envergadura con las armas de que disponían estos

homínidos, hipotéticamente palos afilados y lanzas, no debía ser una

tarea fácil a menos que el animal tuviera alguna patología que lo hacia

más vulnerable. Es interesante el hecho que se constate que los Homo

heidelbergensis, en sus estrategias cinegéticas, tuvieran también como

objetivo estos grades depredadores.

Todo parece indicar un gran incremento de complejidad para