Un fallo en los ordenadores de a bordo causó la pérdida de la sonda rusa Fobos-Grunt, que tenía como destino Fobos, una de las dos lunas de Marte, según ha reconocido el director de la agencia espacial rusa (Roscosmos), Vladímir Popovkin.

|

La nave rusa Fobos-Grunt, antes de su lanzamiento. | Roscomos

|

El jefe de Roscosmos indicó que según la comisión investigadora la causa "más probable" del fallo informático registrado en noviembre pasado fue una "acción local de partículas pesadas del espacio cósmico". "Se produjo el reinicio de dos equipos del sistema de ordenadores de a bordo, que dejó a éste en régimen de máximo ahorro de energía y a la espera de órdenes", dijo Popovkin, citado por la agencia oficial RIA Nóvosti, en una reunión sobre el desarrollo del sector espacial. Las declaraciones de Popovkin echan por tierra algunas versiones adelantadas por expertos rusos acerca de que el fallo de la estación interplanetaria automática pudo ser provocado por emisiones de radares estadounidenses. Poco después de su lanzamiento, el 8 de noviembre del año pasado, la sonda rusa quedó en la órbita terrestre en lugar de emprender su viaje rumbo a Marte, sin control desde las estaciones terrestres de seguimiento. Dos semanas después, la Agencia Espacial Europea consiguió recibir señales de la Fobos-Grunt, un acontecimiento que hizo renacer las esperanzas de recuperar el aparato. Sin embargo, todos los esfuerzos de reanimar la sonda fueron infructuosos y el aparato, con una masa de 13,5 toneladas, se estrelló contra las capas altas de la atmósfera terrestre el 15 de enero pasado. Según Roscomos, los restos de la sonda que no ardieron al entrar en la atmósfera pudieron caer en una zona en el sur del Pacífico, a un millar de kilómetros de las costas de Chile. |

La Fobos-Grunt debía cumplir una misión de 34 meses que incluía el vuelo a Fobos, el descenso a su superficie y, finalmente, el retorno a la Tierra de una cápsula con muestras del suelo del satélite marciano.

El proyecto, con un coste de 5.000 millones de rublos (unos 170 millones de dólares), tenía como objetivo estudiar la materia inicial del sistema solar y ayudar a explicar el origen de Fobos y Deimos, la segunda luna marciana, así como de los demás satélites naturales en el sistema solar.

Fuente: elmundo.es, 31-1-12

![]()

-Europa planea un escudo contra asteroides peligrosos

España es, desde enero, uno de los seis países que investigan cómo evitar que un asteroide peligroso choque contra la Tierra. Se trata de NEOShield, un programa de investigación financiado por la Unión Europea con 4 millones de euros y que durante los próximos tres años y medio estudiará diversas técnicas para desintegrar o desviar a los llamados NEO (siglas inglesas de objeto próximo a la Tierra). Las opciones abarcan desde construir naves lo suficientemente grandes como para desviar la roca con su fuerza gravitatoria a reventarlas con una bomba.

|

Nuestro proyecto incluye la opción nuclear, pero sólo como último recurso", explica a este diario Alan Harris, científico de la Agencia Espacial Alemana, que coordina el proyecto. "En este caso sólo exploraremos de forma teórica cuáles serían los efectos de un impacto nuclear cerca de un asteroide o en su superficie", detalla. Los objetos más grandes no son la prioridad. El meteorito que acabó con los dinosaurios hace 65 millones de años tenía unos 12 kilómetros de diámetro. "Si cayese algo así estaríamos condenados, pero ni siquiera hemos detectado que existan objetos así en el entorno de la Tierra", apunta Harris. Según las estadísticas basadas en impactos pasados, un cataclismo así sólo sucede cada 10 millones de años. El escudo europeo se centra en asteroides mucho más pequeños y frecuentes. Se trata de cuerpos de unos 100 metros de diámetro o más y que serían capaces de destruir poblaciones del tamaño de Londres, explica el experto. "Es muy improbable" que el impacto sucediese en una ciudad, ya que la mayor parte del globo está deshabitada o cubierta por mar, aunque "el rápido crecimiento de la población hace que cada vez cubramos más partes del planeta", argumenta Harris. "La frecuencia de impacto contra la Tierra de un asteroide de alrededor de 1 kilómetro de diámetro es en torno a un millón de años tal y como se ha derivado de los diferentes programas de seguimiento de NEOs", explica Josep Maria Trigo, investigador del Instituto de Ciencias del Espacio (CSIC-IEEC) . |

Sonda Quijote |

Don Quijote

No es la primera vez que Europa planea misiones así. Su intento más reciente fue el proyecto Don Quijote, impulsado por el Agencia Espacial Europea y desarrollado, entre otras, por la empresa española Deimos. Su objetivo era mandar un satélite de reconocimiento llamado Sancho y luego otro de impacto para desviar la roca que se llamaba Hidalgo. El proyecto quedó olvidado en el desván por falta de fondos, aunque podría resucitar en parte, ya que Deimos es una de las 12 instituciones de España, Francia, Alemania, Reino Unido, EEUU y Rusia que desarrollarán NEOShield.

El programa no construirá ningún dispositivo de defensa aún , pero sí estudiará impactos con aire comprimido a velocidades "muy superiores a las de una bala", explica Harris. Estas prácticas de tiro se realizarán en centros de Alemania y Reino Unido y usarán los diferentes minerales que componen los distintos tipos de asteroides. "Después los resultados se aumentarán de escala con ordenadores que simularán el comportamiento del asteroide durante un impacto real", concluye Harris.

Los fondos dedicados a NEOShield no permiten desarrollar un futuro escudo, solo planearlo. Sin embargo, la apuesta de la UE ha sido muy bien recibida por las empresas del sector, ya que es "la primera vez que se aportan fondos para un proyecto así", explicaron ayer fuentes de Astrium. La compañía aeroespacial europea será una de las 12 entidades públicas y privadas que lleven a cabo el proyecto. Para poner en marcha un escudo real hará falta una nueva inversión"de unos 300 millones de euros", según fuentes de la compañía.

Fuente: publico.es, 31-1-12

![]()

-La flora y la fauna de fukushima se analizará durante un año

Japón ha iniciado una investigación para medir los efectos de la radiación procedente de la central nuclear de Fukushima en animales y plantas de las zonas afectadas por el accidente atómico, informó ayer la cadena NHK. La provincia de Fukushima solicitó al Gobierno central que realizara el estudio y el Ejecutivo ha decidido que sea el Ministerio de Medio Ambiente y el Instituto Nacional de Ciencias Radiológicas nipón los que lo elaboren. La idea es que lo presenten en marzo de 2013.

El análisis registrará los niveles de cesio radiactivo en la fauna y la flora investigada en 25 puntos concretos de la provincia de Fukushima, tanto en tierra como en el mar. Entre esos 25 lugares se encuentran las zonas más afectadas por las emisiones de la accidentada planta nuclear y también áreas perjudicadas a menor escala con el fin de comparar los posibles efectos. La selección de las especies que serán investigadas se ha basado en las recomendaciones de la Comisión Internacional de Protección Radiológica.

La Agencia Internacional de la Energía Atómica (AIEA) está considerando abrir una oficina en Fuku-shima que tendría como finalidad asesorar en las labores de descontaminación de la zona.

Fuente: publico.es, 30-1-12

![]()

-La Tierra aguarda la gran erupción solar

En la madrugada del pasado lunes se producía una erupción solar que, poco tiempo después, provocaba preciosas auroras en los extremos de la Tierra. Fue la más intensa de los últimos siete años pero apenas una suave brisa si se compara con la tormenta solar de agosto y septiembre de 1859, que provocó que en latitudes tan bajas como Cuba o España la aurora iluminara la noche, las brújulas de los barcos se volvieran locas y hasta las estaciones de telégrafo ardieran. Sólo el escaso desarrollo tecnológico de entonces evitó el desastre. Hoy, la civilización humana es mucho más dependiente de los caprichos del Sol.

|

La erupción solar de esta semana fue catalogada de clase M8,7 en una escala que incluye los grados A, B, C, M y X, como fue la de 1859. Al igual que en el caso de los terremotos, se trata de un gradiente logarítmico; aquí cada letra refleja una liberación de energía diez veces superior a la anterior. La explosión de radiación proviene de la liberación de la energía magnética asociada a las manchas solares y son el evento más explosivo del sistema solar. "Las llamaradas y erupciones solares son algo así como un, dos, tres, boom", cuenta el científico experto en tormentas solares de la NASA Antti Pulkkinen. "El primer golpe tiene que ver con la radiación electromagnética proveniente de la erupción, y puede durar algunos minutos u horas. El segundo golpe es la generación de partículas que se mueven muy rápido, y esto puede durar varios días. Y después viene lo serio, el tercer golpe, que se produce cuando una nube masiva golpea el área del espacio cercana a la Tierra, y este impacto puede durar varios días", explica. |

Llamaradas solares captadas por el Solar Dynamics Observatory de la NASA el pasado año.NASA / SDO / AIA |

El Sol no sólo es luz; también es un gigantesco campo magnético, con líneas magnéticas recorriendo de polo a polo. Su fuerza rotatoria va torciendo estas líneas imaginarias en un ciclo que dura unos 11 años. En el clímax de su torcimiento se crean las manchas solares en la zona ecuatorial de la estrella. En ocasiones, como esta semana, enormes burbujas de gas y magnetismo se liberan y consiguen superar la barrera magnética (corona) que rodea el Sol, provocando una eyección de masa coronal que sale disparada hacia el espacio. Si la Tierra se encuentra en su trayectoria puede pasar lo peor.

Como explica Pulkkinen, la triple oleada tiene diferentes consecuencias en la Tierra. Lo primero en llegar es la luz, que incluye rayos X y ultravioleta. Esto provoca la ionización de la atmósfera superior de la Tierra, interfiriendo en las comunicaciones de radio. Detrás llega la tormenta de radiaciones. Los astronautas están obligados a protegerse tras un aviso de su llegada. La tercera en venir es la nube de partículas de alta energía. Sus partículas cargadas eléctricamente interactúan con la magnetosfera terrestre provocando fluctuaciones hasta desencadenar una tormenta magnética.

"Esperamos que este evento tenga un impacto moderado. No creemos que haya ningún gran problema con el funcionamiento de los sistemas tecnológicos ni en el espacio ni en tierra", explicaba Pulkkinen antes de que la nube de protones llegara. En efecto, aparte de la multiplicación de las auroras boreales, que se pudieron ver en latitudes algo más bajas, no hubo mayores problemas. Algunas compañías aéreas desviaron los aviones que aprovechan las rutas polares para hacer su trayecto más corto, y poco más.

Pero el ciclo solar está alcanzando su máximo y los científicos esperan que hasta 2013 se produzcan más llamaradas, algunas de gran intensidad. Toda la que alcance la categoría X podría dejar fuera de combate las comunicaciones por radio, alteraría la fiabilidad del GPS, provocaría apagones eléctricos generalizados y hasta radiación en los pasajeros de los vuelos de gran altitud.

"La actividad solar seguirá creciendo en los próximos años. Durante este tiempo esperamos que el número de eventos aumente, así como el tamaño de algunos de los acontecimientos. Los más grandes son raros (como los grandes terremotos o las mayores inundaciones) pero suceden", sostiene el científico de la misión solar SOHO/EIT de la NASA, Alex Young. Para él, la de 1859 fue "la tormenta perfecta" porque se dieron circunstancias para que su impacto fuera grande. Por un lado, la erupción se produjo de frente a la Tierra. Además hay evidencias de que no hubo una sino dos tormentas que se solaparon. La probabilidad de que se repita es baja pero "es posible que nosotros asistamos a un evento tan grande como el de 1859", añade.

Según un estudio de la National Academies de EEUU de 2008, una erupción solar como la de 1859 desencadenaría hoy una tormenta geomagnética que afectaría críticamente a las infraestructuras modernas. Entonces, la llamarada provocó tal nube de partículas que aplastó la magnetosfera. Este círculo invisible de magnetismo protege a la Tierra de los vientos solares y la mayor parte de la radiación cósmica. Su alcance es de unos 60.000 kilómetros pero en 1859 se contrajo hasta los 7.000 kilómetros por la presión invisible que procedía del Sol.

Lo primero que sucedería con una erupción solar de clase X sería que la ionosfera terrestre se calentaría, cambiando su densidad y composición, lo que afectaría a las comunicaciones por radio y a la señal del GPS. Peor aún, puede crear intensas corrientes eléctricas en la ionosfera llamadas electrojets. Estas corrientes provocan un fenómeno eléctrico denominado "centelleo" que cambia la amplitud, fase, polarización y el ángulo de llegada de las señales. Según un informe del Departamento de Seguridad Interior de EEUU, la señal del GPS no sólo llegaría degradada sino que la tormenta geomagnética podría impedir que la Tierra recibiera la señal emitida por los 30 satélites de la constelación GPS.

En tierra, las cosas no serían mejores. La troposfera se cargaría de electricidad de tal manera que hasta el agua de los océanos echaría chispas. Tal cantidad de energía buscaría un camino por donde moverse: de los cables eléctricos a los transformadores, recalentándolos hasta quemarlos. Durante la tormenta de marzo de 1989, la zona occidental de Canadá se quedó a oscuras.

Conferencia preparatoria

"Una tormenta similar en la actualidad nos podría dejar asombrados", explicaba el físico de la NASA Lika Guhathakurta, en una conferencia organizada el verano pasado. Decenas de expertos y responsables del Gobierno acudieron para responder a la pregunta de si estamos preparados para la próxima gran tormenta solar. "La sociedad moderna depende de sistemas de alta tecnología, y todas son vulnerables", añadió Guhathakurta.

El gran problema es que no se sabe cuando será la siguiente tormenta ni su intensidad. Se conoce bien el ciclo solar, se sabe que está a punto de alcanzar su clímax, pero nada más. La NASA y la agencia espacial europea han sembrado los alrededores del Sol de una red de sensores. La mayoría están diseñados para labores de investigación, pero los más recientes, como el Solar Dynamics Observatory, tienen entre sus misiones vigilar la aparición de nuevas erupciones. Son ellos los que pueden avisar con entre 15 o 30 minutos de antelación. Con la información recibida, el Centro de Predicción del Tiempo Espacial de la NOAA (agencia de EEUU) elabora partes diarios para un millar de empresas e instituciones de todo el mundo.

Aunque se está trabajando en modelos informáticos para anticiparse al Sol, lo más realista hoy es prepararse para minimizar su impacto. A finales de 2010, EEUU puso en marcha el programa Escudo Solar. Su primer objetivo es modelar en tres dimensiones la eyección de masa coronal camino de la Tierra. Esta tercera oleada tarda varias horas y hasta un día en llegar. Con el modelo se puede anticipar dónde y con qué intensidad golpeará. En ese tiempo, los responsables de las infraestructuras deberán suspender los elementos clave para evitar que, como en 1859, los telégrafos ardan.

Fuente: publico.es, 29-1-12

![]()

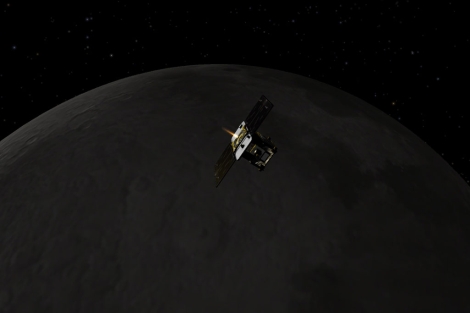

-El carguero ruso Progress se acopla con éxito a la Estación Espacial Internacional

El carguero, lanzado este jueves con ayuda de un cohete portador Soyuz-U que despegó desde el cosmódromo de Baikonur en Kazajistán, se ha enganchado al módulo ruso Pirs en régimen automático.

Los inquilinos de la estación abrieron las escotillas del carguero tras equilibrar la presión atmosférica, mientras la descarga de la nave está prevista para las 19:20 hora de Moscú (16:20, hora penisnular española).

Accidente en agosto

La nave transporta equipos de iluminación, alimentos para los tripulantes de la ISS, facilidades para experimentos científicos, documentación técnica, agua potable y oxígeno entre otras cargas. Rusia reanudó a finales de octubre los lanzamientos de sus cargueros 'Progress' después de casi cuatro meses de suspensión debido al accidente protagonizado por una nave de este tipo que se estrelló en Siberia en agosto de 2011.

La tripulación actual de la ISS está compuesta por seis astronautas: los rusos Oleg Kononenko, Antón Shkaplerov y Anatoli Ivanishin; los estadounidenses Donald Pettit y Daniel Burbank, y el holandés André Kuipers, de la Agencia Espacial Europea.

Fuente: elmundo.es, 28-1-12

![]()

-El primer sapiens emigrante se fue a Arabia

De todos los caminos que anduvo el hombre moderno hasta llegar a la crisis en la que anda metido, los primeros son los más difíciles de descifrar. Sus huellas se borraron hace miles de años y faltan pistas para saber qué ruta tomaron los primeros ancestros sapiens que salieron de África para conquistar el mundo.|

Un supuesto yacimiento sapiens de hace 100 |

Un nuevo estudio aporta hoy evidencias de que la primera migración fuera del continente negro fue por la ruta más arriesgada: a través del Mar Rojo, hace unos 60.000 años. Después de la travesía, los conquistadores se instalaron en Arabia, como demuestran los genes de poblaciones actuales de la zona, según el trabajo, publicado en el American Journal of Human Genetics.De todos los caminos que anduvo el hombre moderno hasta llegar a la crisis en la que anda metido, los primeros son los más difíciles de descifrar. Sus huellas se borraron hace miles de años y faltan pistas para saber qué ruta tomaron los primeros ancestros sapiens que salieron de África para conquistar el mundo

Un nuevo estudio aporta hoy evidencias de que la primera migración fuera del continente negro fue por la ruta más arriesgada: a través del Mar Rojo, hace unos 60.000 años. Después de la travesía, los conquistadores se instalaron en Arabia, como demuestran los genes de poblaciones actuales de la zona, según el trabajo, publicado en el American Journal of Human Genetics. |

El estudio cuestiona la versión más clásica y aceptada: que losHomo sapiens siguieron la costa del este de África y salieron del continente cruzando el Nilo hacia Oriente Próximo.

El nuevo estudio, liderado por la investigadora Luísa Pereira, de la Universidad de Oporto, ha analizado el ADN de 300 europeos y 85 asiáticos para averiguar de qué poblaciones descienden. Su ADN mitocondrial, una porción que transmiten las madres a sus hijos, apunta a tres poblaciones que vivieron hace 60.000 años en Arabia. En otras palabras, los genes han permitido desandar los caminos borrados que recorrieron los primeros migrantes hasta su primer campamento fuera de África. El trabajo no presenta una conexión directa entre estos tres grupos y sus ancestros africanos, pero sí apunta a que estos surgen en una fecha compatible con la de la primera salida de África, hace unos 70.000 años. Los datos de Pereira coin-cidirían con otro estudio publicado en enero de 2011 en Science y que mantuvo que los primeros humanos modernos cruzaron el mar hasta Arabia. En este caso, la prueba eran herramientas de piedra con rasgos inconfundiblemente sapiens que tenían al menos 100.000 años.

Los pioneros pasaron en Arabia unos 10.000 años avanzando luego hacia Oriente Próximo, la fértil Mesopotamia, Asia y Europa, sostiene Pereira. Aprovecharon una etapa de mayores lluvias y vegetación que se extendió hace entre 50.000 años y 24.000 años.

Otro estudio publicado hoy en la misma revista retoma parte de la narración en este punto. Sigue la pista de los primeros humanos que colonizaron América desde un punto desconocido de Eurasia. Investigadores de la Universidad de Pensilvania (EEUU) analizaron el ADN de personas de la república rusa de Altai y el de nativos americanos. En ambas encontraron mutaciones que indican que, hace unos 20.000 años, un grupo de esta población emigró hacia el este y el norte para acabar colonizando América a través del estrecho de Bering. Moraleja: los primeros americanos eran de Altai.

Fuente: publico.es, 27-1-12

-![]()

|

El jabón magnético |

Un grupo de investigadores de la Universidad de Bristol ha anunciado el desarrollo de un nuevo tipo de jabón, cuyas propiedades magnéticas lo convertirían en ideal para la fabricación de productos destinados a la limpieza de desastres ecológicos como los derrames de petróleo crudo. Se trata de un compuesto formado por sales de hierro disueltas en agua cuyas moléculas pueden responder a un campo magnético, propiedad que permite recogerlo junto a la grasa, suciedad y químicos que se le han adherido durante el proceso de limpieza simplemente utilizando un imán. Si logran convertirlo en un producto viable se convertiría en una herramienta muy útil para minimizar el impacto ecológico de estos accidentes.

Desde hace siglos utilizamos jabones y detergentes para remover la

mugre de objetos, utensilios y nuestros propios cuerpos. Pero aunque

estos compuestos hacen un buen trabajo de limpieza, las impurezas

que han removido quedan adheridas a sus moléculas y se van -junto

con el agua utilizada durante el proceso- por el desagüe. Dejando de

lado las consecuencias a largo plazo que puede tener este tipo de

manejo de un recurso tan escaso como el agua potable, lo cierto es

que en el líquido resultante del lavado se mezclan el agua, el

detergente y las partículas removidas, siendo muy complicado separar

una cosa de la otra. Cuando se utiliza alguna clase de jabón para

“limpiar” un derrame de hidrocarburos que ha tenido lugar en el mar,

es muy complicado separar la mezcla resultante del agua limpia.

Afortunadamente, parece que un grupo de investigadores de la

Universidad de Bristol ha encontrado una solución a este problema. |

Reacción a un campo magnético

El equipo de Bristol desarrolló un jabón que incluye en sus moléculas

átomos de hierro. Dicho compuesto utiliza como base un jabón líquido

especial, rico en cloro y bromo. Mientras que en un jabón tradicional

sus largas moléculas solo son atraídas o rechazadas por el agua, en este

nuevo producto se suma la propiedad de que reaccionen frente a la

presencia de un campo magnético. Según Julian Eastoe, uno de los

miembros del equipo de trabajo que creó este jabón, “si hace diez años

le hubiésemos dicho a un farmacéutico que íbamos a disponer de un jabón

capaz de reaccionar a los campos magnéticos difícilmente nos hubiese

creído”.

Pero gracias a su trabajo dicho producto ha sido posible, y en caso de

que pueda ser fabricado en grandes cantidades a un coste razonable se

convertiría en una invalorable herramienta a la hora de enfrentar las

consecuencias de un derrame de combustible en el mar, ya que una vez que

el jabón magnético se ha unido con las partículas del hidrocarburo puede

ser retirado mediante el uso de un imán.

Fuente: abc.es, 26-1-12

![]()

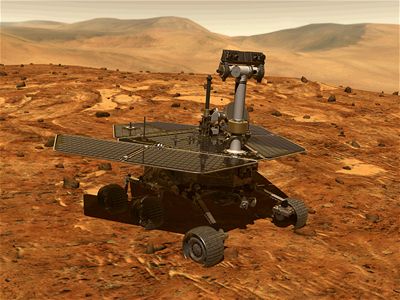

-Opportunity cumple 9 años en Marte

Lo que iba a ser una misión de tres meses se ha convertido en una misión que dura ya ocho años en la que el robot explorador "Opportunity" perdió a su gemelo "Spirit", pero en la que juntos hicieron grandes descubrimientos. "Opportunity" aterrizó en el cráter "Eagle" de Marte el 25 de enero de 2004, tres semanas después de "Spirit", que aterrizó al otro lado del planeta, en busca de señales de agua.|

En "Eagle", un cráter que tiene el tamaño del patio trasero de una casa, fue donde el vehículo explorador encontró evidencias de un ambiente húmedo en el pasado. Pese a que la NASA había diseñado la misión originalmente para tres meses, los robots continuaron transmitiendo fotografías y datos del Planta Rojo. Durante la mayor parte de los siguientes cuatro años, "Opportunity" exploró cráteres cada vez mayores y más profundos, agregando evidencias de períodos húmedos y secos de la misma época que los sedimentos encontrados en el cráter Eagle. A mediados de 2008, los investigadores dieron nuevas instrucciones al robot y éste puso rumbo desde el cráter "Victoria", de unos 800 metros, hacia el cráter "Endeavour", de 22 kilómetros, algo que para los científicos de la NASA ha sido como empezar una nueva misión, por la riqueza de datos obtenidos. Endeavour es una ventana más en el pasado de Marte, señaló John Callas, director del programa de Robots Exploradores de Marte del Laboratorio de Propulsión a Chorro de la NASA, en Pasadena, (California) en un comunicado con motivo del aniversario. El viaje hasta "Endeavour" duró tres años y para llegar hasta el objetivo "Opportunity" recorrió durante su octavo año sobre el Planeta Rojo 7,7 kilómetros, más que cualquier año anterior, que sumados al resto hacen un total de 34,4 kilómetros. |

Opportunity |

Desde agosto, "Opportunity" trabaja en el "Cabo de York", segmento del borde del "Endeavour", donde ha tenido acceso a los depósitos geológicos de un período anterior de la historia de Marte a cualquiera de los examinados durante sus primeros siete años. Los expertos aseguran que el cambio de rumbo ha merecido la pena, "es como empezar una nueva misión", dijo Callas. En medio de esta exitosa carrera, "Opportunity" perdió a su hermano gemelo, cuyas ruedas se atascaron en las arenas marcianas y pese a los intentos de la NASA por salvarlo, dejó de comunicarse con la Tierra en marzo de 2010.

La NASA lanzó el pasado noviembre la nueva generación de robot explorador, "Curiosity", que porta en su interior el Laboratorio Científico de Marte (MSL), con 10 instrumentos para buscar pruebas de un entorno favorable para la vida microbiana, incluidos los ingredientes químicos de la vida.

Fuente: abc.es, 25-1-12

![]()

-El elefante de Sumatra al borde de la extinción

|

En un comunicado,

WWF advirtió de que hoy sólo quedan en Indonesia entre 2.400 y

2.800 ejemplares del elefante de Sumatra (Elephas maximus

sumatranus) en estado salvaje, la mitad de los que había en

1985, tras perder el 70 por ciento de su hábitat en las últimas

dos décadas. "El elefante de Sumatra se une a una creciente

lista de especies en Indonesia que están en peligro de

extinción, como el orangután de Sumatra, el de Java y los

rinocerontes y el tigre de Sumatra", dijo Carlos Drews, director

del Programa Global de Especies de WWF.

La Unión

Internacional para la Conservación de la Naturaleza (UICN) ha

clasificado al elefante indonesio 'en peligro crítico de

extinción' dentro de la Lista Roja de Especies Amenazadas. |

Elefantes de Sumatra |

La isla de Sumatra, en el oeste de Indonesia, mantiene algunas de

las poblaciones más importantes de elefante asiático fuera de la

India y Sri Lanka. Sin embargo, la isla ha experimentado la tasa de

deforestación más rápida de la zona: más de dos tercios de bosques

de llanura en los últimos 25 años, lo que ha provocado la extinción

local de los elefantes en muchas zonas.

En la provincia de Riau (Sumatra), las industrias de pulpa y papel,

así como las plantaciones de palma aceitera, están causando algunas

de las tasas de deforestación más rápidas del mundo, según la

organización protectora de los animales.

WWF hizo un llamamiento al Gobierno indonesio para prohibir todas

las transformaciones de los bosques que forman parte del hábitat de

los elefantes hasta que se ponga en marcha una estrategia de

conservación para estos animales. "La fragmentación hace que el

espacio en que estos animales puedan vivir en libertad se limita a

algunas pequeñas manchas de bosque y las poblaciones no tienen

probabilidades de sobrevivir en el largo plazo", afirmó en el

comunicado.

Según Ajay Desai, experto en elefantes asiáticos, "es muy importante

que el Gobierno de Indonesia, las organizaciones conservacionistas y

las empresas agroforestales reconozcan la crítica situación de los

elefantes y otros animales salvajes en Sumatra, y tomen medidas

eficaces para su conservación". "Indonesia debe actuar antes que sea

demasiado tarde para proteger los últimos bosques naturales de

Sumatra, especialmente el hábitat de los elefantes", concluyó Ajay

Sesai.

Fuente: larazon.es, 24-1-12

![]()

-Descubrir exoplanetas desde casa

El hallazgo de planetas extrasolares es noticia.

Las reglas del juego cambiaron por completo con el inicio de la

misión Kepler en marzo de 2009 y actualmente hay más de 2,300

“candidatos” a planetas extrasolares o exoplanetas, sin mencionar la

gran cantidad de planetas confirmados. Sin embargo, ni Kepler ni los

responsables de su correcto funcionamiento son los únicos que miran

el cielo. A través del proyecto Planet Hunters, uno de los tantos

bajo el portal de ciencia ciudadana Zooniverse, cualquier interesado

podrá estudiar de cerca los datos recogidos por Kepler, para asistir

en la búsqueda de nuevos planetas.

|

Un término que se ha adaptado muy bien a la astronomía es el de

la cacería. Entusiastas y expertos por igual invierten recursos

para cazar cometas, asteroides, y por supuesto, planetas. Son

los denominados exoplanetas los que actualmente resultan

cautivadores, especialmente para los medios de información.

Desde que se inició la misión Kepler se ha recolectado una

enorme cantidad de datos, y hasta finales de diciembre de 2011

había más de dos mil candidatos a exoplanetas, con algunas

detecciones realmente formidables. De más está decirlo, queda

mucho terreno por cubrir. |

|

Un millón de clasificaciones

Como puedes ver, el proceso básico es bastante sencillo, pero no

estará de más que hagas una visita a la sección de tutoriales para

que puedas afinar un poco la puntería a la hora de detectar estas

variables. Recientemente, el programa de televisión Stargazing Live

de la BBC invitó a los televidentes a participar en Planet Hunters.

En apenas 48 horas se superó la barrera del millón de

clasificaciones, e incluso fue posible detectar un nuevo planeta del

tamaño de Neptuno orbitando la estrella denominada SPH10066540.

Hay muchas estrellas para explorar, y con un poco de suerte, uno de

sus planetas podría ser bautizado con tu nombre. La clave de Planet

Hunters es la participación. Esto no es como proyectos al estilo de

SETI@Home en donde el ordenador hace todo el trabajo. Planet Hunters

tiene un superordenador, pero está formado por los cerebros de cada

uno de sus participantes. ¿Interesado?

Fuente: abc.es, 23-1-12

![]()

-El viaje del Louvre a Fukushima y otras fábulas radiactivas

Ralph Lapp, el físico que acuñó el concepto de Síndrome de China, dijo: "Como los impuestos, la radiactividad lleva mucho tiempo con nosotros y en cantidades cada vez mayores; no debe ser odiada ni temida, sino aceptada y controlada". El accidente de la central japonesa de Fukushima no ha hecho sino desorbitar esos temores hacia lo radiactivo, a veces hasta el paroxismo. El recelo frente al trébol amarillo que alerta ante la radiación, icono creado en 1946 en la Universidad de Berkeley, es lógico, pero también se alimenta con bulos, leyendas, chismes y ficciones.

|

Una de las piezas del Louvre que viajarán a Fukushima. |

El presidente de la Royal Society de Química, David Phillips, defendió en la BBC que los villanos de James Bond contribuyeron a consolidar el miedo a la energía nuclear tanto como Chernóbil y Fukushima: "El Dr. No, con su propio reactor atómico, ayudó a crear una reputación de la energía atómica despiadadamente siniestra". En la película, que cumple 50 años, el malo muere en la piscina de refrigeración de su reactor, derrotado por Sean Connery. "Digamos sí a la energía nuclear y no a las tonterías del Dr. No", zanjó Phillips. Tonterías se han dicho a espuertas desde el pasado 11 de marzo, fecha del accidente en la central nipona. Un simple googleo llevará al internauta a descubrir que un OVNI se paró sobre las instalaciones de Fukushima durante los días más críticos, que la diseminación de la radiación es un plan de alienígenas reptilianos para conquistar el planeta o que el terremoto que provocó el accidente fue desatado por EEUU a través de su Agencia de Investigación de Proyectos Avanzados de Defensa (DARPA). Y es verdad que DARPA está implicada en la catástrofe de Fukushima, pero porque su tecnología hizo posible que un robot registrara imágenes de los reactores desde cerca. Todavía hoy siguen surgiendo polémicas radiactivas. La última ha implicado a la más prestigiosa pinacoteca del mundo. Los responsables del Museo del Louvre, en París, han querido tener un gesto de concordia hacía los japoneses afectados por la catástrofe y han decidido enviar una pequeña muestra de 23 obras a las localidades damnificadas. La exposición itinerante, que lleva por meloso título Encuentros, amor, amistad y solidaridad en las colecciones del Louvre, fue dada a conocer por el historiador del arte Didier Rykner en un duro artículo publicado en la reputada revista que dirige, La Tribunede l'Art, en el que se oponía a que estas piezas realizaran un viaje tan "peligroso". Entre las obras de la muestra, financiada por mecenas nipones, se cuentan desde cuadros rococós hasta esculturas mesopotámicas, junto a figurillas egipcias, mármoles griegos y miniaturas persas. Entre abril y septiembre, el museo paseará este conjunto tan variopinto como valioso por las prefecturas más golpeadas, incluida la capital de Fukushima. |

A Rykner, quien asegura que "tal exposición es difícil de imaginar en Haití", le inquieta especialmente que esas creaciones se expongan no sólo al público, sino a la radiación. "Dos de las tres ciudades que comprende el recorrido se encuentran en las regiones contaminadas por el desastre nuclear de Fukushima. Sólo el Museo del Louvre nos podría decir en serio, sin ningún intento de humor, que las medidas tomadas en estas tres ciudades no presentan un nivel de radiactividad inusual".

Rykner lamenta que la pinacoteca no haya consultado al Instituto para la ProtecciónRadiológica y la Seguridad Nuclear (IRSN) y cita a esta institución que recomienda que aquellos franceses que acudan a esas zonas pasen regularmente la aspiradora a los objetos con el fin de limitar la transferencia de partículas de polvo contaminadas. "Pero ¿qué pasa con las pinturas y la tapicería flamenca del siglo XVI, que el Louvre envía para allá? ¿También tienen que ser aspiradas regularmente?", se pregunta el experto.

Estudios peligrosos

Hay un efecto de la radiación mucho peor que deteriorar joyas artísticas: la muerte de las personas. De momento, la catástrofe de los tres reactores japoneses no ha provocado ni una sola muerte. En Japón al menos. Porque el investigador Joseph Mangano acaba de publicar un artículo titulado Inesperado aumento de la mortalidad en EEUU tras la llegada de la nube radiactiva de Fukushima: ¿existe una correlación? en el que insinúa que han muerto 14.000 personas por culpa de Fukushima... a 12.000 kilómetros de allí, al otro lado del Pacífico.

Mangano, cuyo trabajo ha sido calificado de "basura" en Forbes, toma las cifras oficiales de mortalidad inesperada de las 122 principales ciudades de EEUU, extrapola, calcula y relaciona. Cuestionado por sus resultados, Mangano responde por email: "Yo no digo que Fukushima las haya matado, sino que es el único factor que explica estas muertes". Y añade: "Asumir que nadie ha muerto en Japón por la radiación es un error. Si no hay muertos es porque todavía no se ha hecho un estudio sobre la materia". En EEUU llaman Ratoncito Pérez a Mangano desde que trató de relacionar el estroncio de los dientes de los niños con una central de Nueva Jersey.

Más allá de fábulas, hay historias como la del presentador japonés al que se le diagnosticó leucemia unos meses después de comer productos de Fukushima en su show, por lo que cuesta asumir la radiactividad con la naturalidad que pide Lapp. Aunque él participó en el Proyecto Manhattan de EEUU para desarrollar la primera bomba atómica. Y eso sí da miedo.

Fuente: publico.es, 22-1-12

![]()

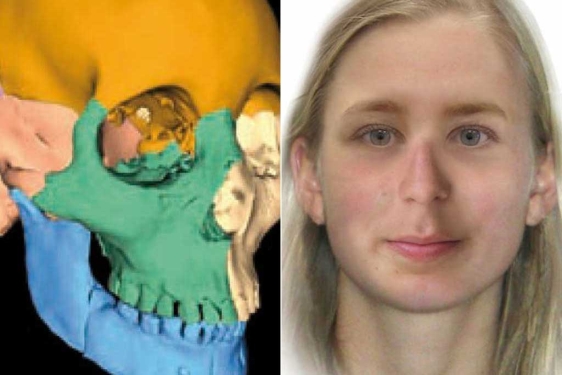

-La ciencia resuelve el misterio del cadáver de la joven Moore, hallado en Alemania

|

La ciencia, detective implacable, ha conseguido descifrar el misterio de Moora, la joven cuyos restos aparecieron esparcidos en una zona pantanosa cerca de Hannover. Un primer análisis de aquel cadáver excepcionalmente bien conservado apuntó a una mujer de entre 17 y 19 años de edad que podría haber muerto en extrañas circunstancias porque algunos de los huesos presentaban deformaciones. La policía sospechó en un primer momento que el cadáver estaba relacionado con una desaparición de una joven de 16 años en 1969, nunca resuelta, pero las pruebas de ADN permitieron descartarla. El caso, entonces, fue a parar a los archivos. Cinco años más tarde, el 5 de Enero de 2005, apareció en la misma zona una mano derecha humana y con las huellas digitales intactas que inmediatamente fue asociada a los restos Los forenses advirtieron la presencia de sustancias propias de una momificación y así fue como el caso pasó al campo de la arqueología. Los arqueólogos Hennig Haßmann y Andreas Bauerochse realizaron la datación por radiocarbono en la Universidad de Kiel, sorprendiendo a todos con una antigüedad de 2.600 años. La chica había muerto entre el 764 y el 515 antes de Cristo. Los investigadores, antes de ponerse manos a la obra, la bautizaron como Moora, dado que pantano en alemán se dice Moor. |

La mano apareció en la misma zona en 2005. |

Tras seis años de trabajo científico, hoy lo conocemos casi todo sobre ella. Gracias a un equipo multidisciplinar compuesto por paleontólogos, profesionales de la justicia, antropólogos y arqueólogos, sabemos por ejemplo que era zurda, que su cabello era ligeramente pelirrojo y que vivió en lo que hoy es Baja Sajonia, en la Edad de Hierro prerromana, llevando una existencia llena de penurias y sufrimientos.

Según el experto en huesos Dennis Saring, del Hospital Universitario Hamburg-Eppendorf, de niña sufrió al menos dos fracturas parciales de cráneo que tuvieron tiempo de soldar solas y padeció largos periodos de enfermedad fácilmente asociables a largos inviernos de privaciones. Las líneas de crecimiento de los huesos revelan que durante toda su infancia y adolescencia sufrió una desnutrición crónica y un ejercicio físico duro que estaría relacionado posiblemente con el traslado de grandes vasijas cargadas con agua sobre su cabeza.

Reconstrucción del rostro

El semanario 'Der Spiegel' ha publicado la reconstrucción de su rostro, llevada a cabo por la Policía Criminal del estado de Sajonia-Anhalt y expertos de las Universidades de Friburgo y Dundee (Reino Unido), unas facciones que, en cuanto fueron presentadas al equipo de expertos, sirvieron de estímulo a los investigadores, a esas alturas ya muy encariñados con Moora y con el proyecto de desvelar las causas de su muerte.

Los paleontólogos han diagnosticado que la muchacha de la ciénaga tenía un tumor benigno en la base del cráneo, lo que terminó ocasionando una curvatura en la columna vertebral y una inflamación crónica en los huesos de las piernas. Pero la cuestión de cómo y por qué 'Moora' murió permanece abierta.

Uno de los principales interrogantes es por qué estaba desnuda, ya que es evidente que no hay restos de ropajes ni joyería. Otra pregunta es por qué su cuerpo no fue cremado, según las costumbres funerarias de la época. El equipo de antropólogos considera que su trabajo podría consistir en cruzar el páramo pantanoso haciendo equilibrios sobre un estrecho puente o pasarela de troncos flotantes en el fango y llevando algún tipo de carga.

El área que cruzaba debió ser importante para su grupo, no solamente como fuente de alimentos o agua, sino también por su significado religioso. La zona en la que aparecieron los restos ha sido intensamente estudiada, pero no han aparecido más, según el jefe de la Oficina de Monumentos, Stefan Winghart y la investigación ha llegado a un callejón sin salida, pero la mirada de Moora sigue motivando a los investigadores, que saben que el puzle de su muerte están aún por completar.

Fuente: elmundo.es, 21-1-12

![]()

-Nueve de los 10 años más cálidos han sido en el siglo XXI

La temperatura media global de 2011 fue la novena más elevada en los registros meteorológicos modernos, continuando una tendencia de acumulación de gases de efecto invernadero que ha provocado quenueve de los 10 años más cálidos conocidos hayan ocurrido desde 2000, afirman científicos de la NASA.

La temperatura superficial global promedio para 2011 fue 0,51ºC más caliente que la temperatura media de base para el siglo XX, según afirman investigadores del Goddard Institute for Space Studies, informa Reuters. Los registros de temperatura de esta institución científica empezaron en 1880.

Los primeros 11 años del nuevo siglo fueron notablemente más calientes que la segunda mitad del siglo XX, según asegura el director del instituto,James Hansen, uno de los más destacados expertos mundiales en cambio climático. El único año no perteneciente al siglo XXI que se 'cuela' entre los 10 más cálidos es el cercano 1998.

Estas temperaturas globales tan altas ocurren incluso cuando hay situaciones coyunturales que llevan al enfriamiento, como es un fuerte fenómeno oceánico de La Niña, que enfría la temperatura del océano, y una baja actividad solar durante los últimos años.

Un comunicado de la NASA asegura que las temperaturas actuales son superiores a la media por las crecienntes concentraciones de gases de efecto invernadero en la atmósfera, especialmente el dióxido de carbono. El dióxido de carbono es emitido por diversas actividades humanas especialmente por la quema de combustibles fósiles como el carbón, el gas y el petróleo.

Los niveles actuales de dióxido de carbono en la atmósfera superan las 390 partes por millón, frente a las 285 partes por millón que había en el siglo XVIII y las 315 partes por millón que había en 1960.

Fuente: elmundo.es, 20-1-12![]()

-España busca marcianos en la "Antártida"

Marte está en la Tierra. En el planeta azul hay rincones cuyas temperaturas bajo cero, desiertos de sal y cegadoras tormentas de polvo son lo más parecido al planeta rojo que ha pisado el hombre. Los Martes de la Tierra se reparten por todo el globo. Uno está a cuatro kilómetros bajo tierra, en las galerías de las minas de Suráfrica. Otros, en los llanos pelados del desierto de Atacama, en Chile, o en los terrenos rojos y ácidos de Río Tinto, en Huelva, o incluso en los hielos perpetuos de la Antártida. Para sorpresa de los científicos, en todos estos lugares se ha hallado vida en forma de microorganismos obstinados que podrían resistir muchas de las inclemencias del tiempo en Marte. Encontrar a estos seres y estudiar sus mecanismos de supervivencia son clave para entender la posibilidad de que haya vida en el planeta rojo y diseñar la máquina perfecta para encontrarla.

|

La base antártica española Gabriel de Castilla será el centrode operaciones de la nueva misión del detector SOLID.

|

La próxima semana, un equipo de investigadores españoles saldrá hacia la Antártida para poner a prueba una de las máquinas rastreadoras de vida más sofisticadas que se han ideado. Se trata de SOLID o Signs Of Life Detector, detector de señales de vida. SOLID, una especie de ruleta rusa de siete kilos, ha sido diseñado para ir directo al grano: encontrar seres vivos en el planeta. "Este es el detector más directo para encontrar restos de vida en Marte", explica a este diario Víctor Parro, investigador del Centro de Astrobiología de Madrid CAB (CSIC-INTA) y responsable del proyecto. La idea de SOLID es tan simple como arriesgada. Hasta el momento, todos los instrumentos que se han enviado al planeta rojo tenían como objetivo, de una forma u otra, encontrar vida presente o pasada en su superficie. Sin embargo, el objetivo oficial de esas misiones no incluía la detección de vida por un motivo muy simple: si la misión no hallaba nada podría ser concebida como un fracaso. Ni siquiera el robot de exploración Curiosity de la NASA, que en estos momentos viaja hacia Marte, tiene el objetivo expreso de hallar vida. En su lugar, sus sensores buscarán aminoácidos, los ladrillos de las proteínas, componentes orgánicos que podrían señalar que en la tierra que pise el robot hay o hubo algo vivo en el pasado, aunque no podrá determinarlo de forma concluyente. "Nosotros no buscamos aminoácidos, sino moléculas biológicas más complejas como las de la Tierra", detalla Parro. El mayor obstáculo para buscar vida en Marte está en la mente humana. El hombre ha definido lo que es la vida observando los seres que habitan su planeta. Este geocentrismo fomenta una cerrazón que impediría detectar variantes biológicas nunca observadas en el planeta azul. |

Para minimizar esta posibilidad SOLID va armado con un catálogo de entre 400 y 500 anticuerpos para detectar otras tantas moléculas que sólo podrían haber sido producidas por algo vivo. Entre ellas están el ADN, columna vertebral de la vida en la Tierra, grasas que se han detectado en todas y cada una de las bacterias conocidas y un tipo de azúcares llamados polisacáridos y cuya presencia delata a un ser vivo en plena lucha por la supervivencia.

Los microorganismos usan polisacáridos para protegerse de los entornos fríos, explica Parro. Estas moléculas hacen que el agua en torno suyo siga líquida incluso a temperaturas de diez grados bajo cero. "Si Marte está en condiciones similares a las que encontramos en algunos lugares de la Tierra, debe haber allí mecanismos similares para sobrevivir", detalla el investigador.

El catálogo de anticuerpos de SOLID ha sido confeccionado durante años de viajes a los diversos análogos de Marte en la Tierra.

El instrumento ha demostrado su capacidad para destapar microorganismos en las minas surafricanas, el permafrost de la Antártida, las antiguas minas de Río Tinto y el desierto de Atacama, el lugar más árido del planeta. Fue allí donde Parro y su equipo quedaron más sorprendidos.

SOLID analizó tierra sacada a cinco metros bajo la misma, en un entorno "con mucha sal y nitratos donde no se esperaba encontrar gran cosa", recuerda Parro. Pero el detector señalaba que allí había vida.

"Después, en el laboratorio, vimos que aquella tierra contenía microorganismos y que estos volvían a la vida al añadir agua", señala Parro. Los investigadores bautizaron a estas colonias de microorganismos obstinados como "micro oasis" en un reciente estudio publicado en Astrobiology. Su idea es que Marte puede esconder idénticos oasis de vida microbiana. "En estos terrenos, el cloruro sódico, básicamente sal de mesa, tiene gran capacidad de atrapar agua y hacer que esta permanezca en estado líquido incluso en temperaturas bajo cero", explica el investigador. En este tipo de entornos salinos se han detectado en la Tierra "salmueras con vida" a unos 15 grados bajo cero, señala Parro. En Marte, donde abunda el tipo de sales iguales a las de la Tierra, "podría también haber esas salmueras" a esas temperaturas bajo cero, añade.

El próximo jueves comenzará la nueva misión de SOLID. Esta vez irá a Cerro Caliente, un paradójico enclave antártico de la Isla Decepción donde la temperatura pasa de los dos grados bajo cero en superficie a entre 60 y 100 grados positivos. El Cerro Caliente, cercano a la base española Gabriel de Castilla, es ideal para buscar organismos capaces de vivir en "gradientes térmicos" como los que hay en zonas hidrotermales del fondo marino. "Aunque es algo que hoy se discute, algunos investigadores piensan que en Marte hubo actividad hidrotermal reciente", añade.

Parro y el resto de su equipo colaboran con la NASA. Su objetivo es mandar su cazador de vida, que ha costado "unos tres millones de euros", a bordo de una futura misión de la agencia. Por ahora no han logrado ganar una convocatoria para hacerlo.

El equipo de Parro fuederrotado en el año 2004 por su máximo rival, el Life Marker Chip desarrollado por el astrobiólogo Mark Sims, de la Universidad de Leicester (Reino Unido). Su detector está diseñado para encontrar signos de vida extinta, y ganó el concurso para viajar a Marte a bordo de ExoMars, un robot impulsado por la Agencia Espacial Europea y la NASA que saldría en 2018. "El objetivo de SOLID se centra en la vida presente, nosotros, en formas que llevan muertas 3.000 o 4.000 millones de años", explica a Público Sims. Muchos expertos dudan de que haya vida presente en el planeta rojo y la elección de Sims era muestra de ello.

El investigador británico recuerda que, hace años, la idea era crear un detector conjunto con sus homólogos del CAB. "Llegó un punto en el que no pudimos alcanzar un acuerdo y comenzaron a desarrollarse dos instrumentos", recuerda.

Equipos rivales

Sea como sea, la victoria de Sims se ha agriado. El año pasado la NASA anunció que no tiene fondos para completar su aportación a ExoMars. En consecuencia, Europa, EEUU y Rusia están rediseñando la misión, que podría dejar en tierra muchos componentes. "Todavía no sabemos si viajaremos en ExoMars", lamenta Sims, que no repara en elogios a sus competidores: "Les deseo mucha suerte porque su instrumento es muy bueno".

Tanto Sims como Parro reconocen que gran parte del futuro sobre la exploración marciana depende de lo que encuentre el robot Curiosity, que en agosto aterrizará en Marte. Parro explica que su equipo se presentará a la nueva convocatoria de la NASA para misiones de coste medio y bajo. La falta de dinero podría jugar en su favor, ya que los recortes de presupuesto podrían hacer que la NASA decida regresar a un punto de Marte ya visitado para ahorrar dinero, explica.

"Si Curiosity encuentra compuestos orgánicos, esto reforzaría la necesidad de enviar ExoMars así como otras misiones para buscar vida", opina Sims, que da una de cal y otra de arena cuando se habla del futuro. "La posibilidad de que haya vida extinta en Marte sigue siendo más probable, pero estaría muy contento de que me contradijeran", concluye.

Fuente: publico.es, 19-1-12

![]()

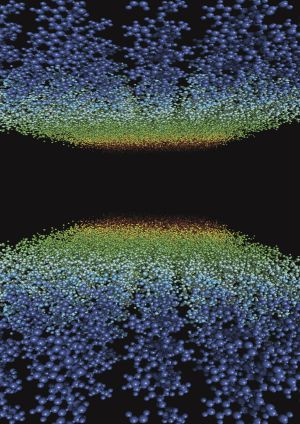

-Crean el primer "Universo Oscuro"

No podemos verla, ni tocarla, ni interactuar con ella de forma alguna, pero sabemos que está ahí por los efectos que tiene sobre las cosas que sí podemos ver. La materia oscura da cuenta de un 23% de la masa del Universo, mientras que la materia ordinaria, de la que están hechas las galaxias, las estrellas, los planetas y nosotros mismos, apenas si supone un 4% del total. Ahora, y por primera vez, los astrónomos han conseguido elaborar un mapa detallado de la distribución de la materia oscura en una vasta región de mil millones de años luz.

El mapa, realizado por un equipo internacional de astrónomos liderado por Catherine Heymans, de la Universidad de Edimburgo, y Ludovic Van Waerbeke, de la Universidad de British Columbia, muestra cómo la materia oscura se concentra en grandes masas y largos filamentos, con enormes regiones vacías entre ellos. La materia oscura no emite luz (de ahí su nombre), pero ejerce una poderosa fuerza gravitatoria que afecta a los objetos de materia ordinaria que hay alrededor. Se supone que está formada por alguna clase de partículas desconocidas y, como se ha dicho, es mucho más abundante que la materia ordinaria que forma las estrellas y las galaxias.

|

"Sabemos muy poco sobre el Universo oscuro -afirma Catherine Heymans- No sabemos cómo ni lo que es una partícula de materia oscura. Y es muy duro pensar que la comprensión final del universo oscuro depende de la invocación de algún tipo de nueva física". Realizar un mapa de algo que no se puede ver puede parecer una tarea imposible, pero en realidad no resulta demasiado complicado. Si un hipotético hombre invisible se acostara en nuestra cama, dejaría arrugas en las sábanas. Es decir, que sabríamos de su presencia aunque no pudiéramos verle directamente. De la misma forma,la materia oscura causa pequeñas distorsiones en las formas de las galaxias del fondo cósmico, algo parecido a lo que haría una lente que deforma lo que vemos detrás de ella. En otras palabras, los investigadores midieron un efecto llamado "lente gravitacional", que sucede cuando la gravedad de un cuerpo muy masivo dobla el espacio-tiempo, haciendo que la luz que viaja a través de esa zona se curve y parezca distorsionada cuando llega a la Tierra. "Resulta fascinante ser capaces de 'ver' la materia oscura usando una distorsión espacio temporal -afirma Van Werbeke-. Un efecto que nos proporciona un acceso privilegiado a esta misteriosa parte de la masa del Universo que no puede ser observada de otra forma. Conocer cómo se distribuye la materia oscura es un primer paso hacia la comprensión de su naturaleza y de cómo ésta encaja con nuestros actuales conocimientos de Física". |

Utilizando esta técnica, los investigadores descubrieron la presencia de la materia oscura y calcularon su distribución en una vasta región de más de mil millones de años luz. Los resultados fueron presentados ayer por Heymans y Van Werbeke en la 219 Conferencia de la Sociedad Astronómica Americana que se celebra estos días en Austin, Texas. Y se parecen bastante a las simulaciones realizadas con superordenadores sobre la evolución del Universo. La materia oscura se concentra en grandes masas y largos filamentos que forman una tupida red. Los nudos de esa red, donde se concentra la mayor cantidad de materia oscura, coinciden a la perfección con los grandes cúmulos de galaxias.

Utilizando una de las cámaras del telescopio franco canadiense de Hawaii (CFHT), los investigadores invirtieron cinco largos años para obtener imágenes de diez millones de galaxias, todas ellas a una distancia de unos 6.000 millones de años luz. Sus distorsiones revelaron cómo se distribuye la materia oscura que hace de "lente". El resultado es un mapa cien veces más grande que el mayor del que se disponía hasta ahora.

Fuente: abc.es, 18-1-12

![]()

-La "Niña" propicia las pandemias de gripe

|

Un mexicano intenta protegerse de la epidemia de gripe A en abril de 2009.-REUTERS |

La respuesta ante las grandes pandemias que, de cuando en cuando,

golpean a la humanidad es un grave problema global que podría

abordarse con mayor margen de maniobra si los expertos pudieran

adelantarse a su estallido. O, al menos, saber qué condiciones son

más propicias para la difusión de virus especialmente resistentes a

lo ancho y largo del planeta. Una buena pista sería saber si esa

difusión está ligada a algún fenómeno climático. Y, al parecer, es

lo que sucede con las pandemias de gripe, que suelen sacudir el

planeta asociadas a un acontecimiento tan poderoso y reconocible

como es El Niño. En este caso, se trata de la parte del

ciclo conocida como La Niña.

Es lo que se proponen los investigadores de las universidades de Columbia y Harvard que publican en el último número de la revista PNAS cómo las últimas cuatro grandes pandemias de gripe (1918, 1957, 1968 y 2009) tuvieron lugar después de que La Niña se manifestara rebajando sensiblemente la temperatura de la superficie del Pacífico ecuatorial. El nexo entre las temperaturas propiciadas por La Niña y los estallidos pandémicos estaría en las aves y sus hábitos, según este estudio. Así, las aves salvajes, que son conocidas por ser la principal reser-va de buena parte de los virus de la gripe, ven alterado su comportamiento como consecuencia de los ciclos asociados a El Niño. Este fenómeno climático afecta a las temperaturas, las precipitaciones y la velo-cidad y dirección del viento, lo que provoca cambios determinantes en la población, las migraciones y sus escalas e incluso en sus mudas. |

Los cambios en los movimientos de las aves provoca, en algunas ocasiones, mutaciones en los virus de la gripe que ellas mismas ayudarían a diseminar a gran escala por todo el globo. Para llegar a esta conclusión, los investigadores analizaron lo ocurrido en las últimas grandes pandemias de gripe y vieron que todas brotaron en los primeros meses del año, justo después de un otoño y un invierno especialmente afectados por La Niña.

La pandemia de 1918, que mató a cien millones de personas, surgió en marzo; la de 1957 (mató en torno a dos millones), en febrero; la de 1968 (un millón), en julio; y la de la gripe A, como la llamó la Organización Mundial de la Salud, comenzó a afectar a personas (acabó con la vida de 18.000) desde marzo de 2009. En los cuatro casos se registraron temperaturas especialmente bajas en el Pacífico ecuatorial durante los seis meses anteriores en cada caso, un escenario climático coherente con los efectos de La Niña.

Fuente: publico.es, 17-1-12

![]()

- El ADN de Napoleón revela que tenía orígenes caucásicos y no árabes

Nuevos análisis de ADN establecen que los orígenes del emperador Napoleón I (1769-1821) eran caucásicos y no árabes, como se especulaba hasta ahora, según las investigaciones del profesor Gérard Lucotte publicadas este lunes en la prensa francesa.

|

La ilustración muestra el árbol genealógico de Napoleón (c). | EL MUNDO

|

A partir de varios cabellos que pertenecieron a las patillas de Napoleón, avalados por haber aparecido junto con un relicario que perteneció al fundador del Museo del Louvre, Dominique Vivant-Denon, el genetista pudo aislar el perfil del cromosoma Y de Napoleón, informa 'Le Figaro'. Se trata del mapa genético masculino del emperador Bonaparte, nacido en Córcega y de quien se creía que podía tener orígenes árabes pues se le conocía un vínculo familiar con el mercenario del siglo XV al que llamaban 'Il Moro di Sarzana', originario de una ciudad mediterránea recurrentemente atacada por los sarracenos. Se cotejó la muestra con la de familiaresEfectivamente, el 'haplogrupo' del ADN analizado, que sirve para definir la historia de los ancestros de una persona, coincide con un tipo extraño y llamado Elblbcl que se ha encontrado en el 10% de la población de Yemen y Arabia Saudí, según los estudios de Lucotte publicados en la revista especializada 'Journal of Molelular Biology Research'. "Las indicaciones históricas hacían pensar a los expertos que los ancestros árabes de Napoleón habrían llegado a Europa durante la expansión del Islam o a través del comercio de mercancías con Italia", resume 'Le Figaro'.

|

Sin embargo, Lucotte ha echado por tierra esa teoría. El genetista tuvo la oportunidad de cotejar cabellos de las patillas del emperador con el material genético de Charles Napoleón, descendiente por la parte de Jerónimo Bonaparte, hermano de Napoleón. Las marcas del cromosoma Y del contemporáneo Charles Napoleón y las del emperador que dominó Europa entre los siglos XVIII y XIX se revelaron idénticas.

Su muerte sigue siendo un misterio

"Hemos podido determinar el 'halopgrupo' sobre un mayor número de marcadores, con mucha más precisión: Napoleón no era árabe sino caucásico", asegura Lucotte.

Aunque publicados, la comunidad científica no dará por válidos los resultados hasta que un segundo laboratorio desarrolle la misma investigación. No obstante, mientras tanto se abren nuevos caminos para explorar, como las causas de la muerte de Napoleón, nunca esclarecida. O aclarar, al menos, si pudo padecer alguna enfermedad genética. Recientes investigaciones llevadas a cabo a partir de muestras de cabello cortadas tras su muerte han revelado que contenían arsénico, sugiriendo que Napoleón podría haber muerto envenenado.

Detrás de las investigaciones científicas, escribe 'Le Figaro', se esconde una nueva tentativa de abrir la tumba de Napoleón en el Hotel de los Inválidos de París y aclarar si efectivamente allí yacen los restos del emperador, si se trata del cadáver de otra persona o si el sepulcro está vacío.

Fuente: elmundo.es, 16-1-12

![]()

-La muerte de un científico a manos de otro en Oxford

|

Steven Rawlings y Devinder Sivia, en la información publicada en la web de 'The Telegraph'.

|

El brutal asesinato de un profesor de Astrofísica ha conmocionado Oxford. El cuerpo sin vida y brutalmente apaleado de Steven Rawling, 50 años, apareció en el apartamento de otro profesor universitario, Devinder Sivia (49 años), con quien escribió hace 13 años un libro titulado 'Fundamentos Científicos de las Matemáticas'. La policía detuvo el jueves a Sivia, de origen hindú, como principal sospechoso, aunque hoy mismo ha sido puesto en libertad bajo fianza mientras se espera el resultado de la autopsia. La policía cree que Rawling murió de un fallo cardiaco como consecuencia de la paliza recibida.

"Lo único que podemos confirmar de momento es que los dos fueron buenos amigos durante 30 años", ha dicho un portavoz de la policía local. "Seguimos investigando todas las circunstancias que puedan haber llevado a su muerte". La policía encontró el cadáver de Rawling tras recibir una llamada de un vecino, alertado por el ruido en el apartamento. Otro vecino entró en el lugar de los hechos e intentó revivir a Rawling mientras agonizaba en el suelo y en presencia de su viejo colega y presunto agresor. |

Discusión

El profesor Sivia fue esposado por la policía en el mismo lugar de los hechos. El sospechoso confesó que los dos habían discutido y dijo que actuó "en defensa propia", aunque no explicó las razones de la pelea.

Pese a la vieja colaboración, los dos enseñaban Astrofísica en dos escuelas unversitarias rivales dentro del campus de Oxford: St. Peters (Rawling) y St Johns (Sivia). La policía baraja la hipótesis de una "discusión académica", aunque no descarta otros posibles móviles. Rawling estaba casado y fue recordado ayer como "un gran astrónomo" por sus alumnos. Sivia vivía solo y tenía fama de ser "amable y generoso".

"Toda la comunidad universitaria están profundamente afectada por la tragedia del profesor Rawlings", ha declarado el vicecanciller de Oxford Andrew Hamilton. El caso guarda un extraño paralelismo con uno de los episodios más populares de la serie televisiva 'Inspector Morse', en la que el personaje encarnado por John Thaw investiga una serie de "crímenes académicos" en la ciudad univesitaria.

Fuente: elmundo.es, 13-1-12

![]()

-La Vía Láctea al menos 100000 millones de planetas

La Vía Láctea contiene, al menos, 100.000 millones de planetas, según revela un censo planetario realizado por un equipo de astrónomos y difundido hoy durante la reunión anual de la Sociedad Astronómica Estadounidense. Los resultados se basan en observaciones realizadas durante seis años en colaboración con el programa PLANET (Probing Lensing Anomalies NETwork), una red de telescopios que toman medidas fotométricas de las estrellas.

Los científicos han llegado a esta cifra gracias a la técnica de microlentes gravitacionales, que puede utilizarse para detectar la presencia de objetos masivos, como agujeros negros, o planetas extrasolares. Se trata de un fenómeno que forma la luz cuando procede de objetos distantes y brillantes al curvarse alrededor de un objeto masivo, como una galaxia, y que permite detectar la diferencia de brillo en una estrella si pasa un planeta por delante.

A diferencia de otras técnicas de detección de planetas, que miden las sombras de los planetas al pasar por delante de sus estrellas o el bamboleo de una estrella debido al tirón gravitatorio de un planeta, la técnica de la microlente gravitacional permite captar planetas más pequeños o que están más lejos de su estrella. El equipo ha estudiado 100 millones de estrellas entre 3.000 y 25.000 años luz de la Tierra y han combinado sus resultados con estudios anteriores, utilizando otras técnicas, para crear una muestra estadística de estrellas y planetas que las orbitan, que según los autores es la más completa de la galaxia.

El cruce de datos revela que cada estrella de nuestra galaxia contiene, en promedio, un planeta, lo que demuestra que a pesar de lo que se pensaba hasta hace unos años, no es algo tan raro que una estrella tenga su propio sistema planetario como el Sol. Utilizando la técnica del microlente, los astrónomos pueden determinar la masa de un planeta, aunque este método no revela ninguna pista sobre su composición.

Los investigadores han concluido que hay muchos más planetas pequeños que grandes, del tamaño de Mercurio, Venus, la Tierra y Marte, lo que abre la posibilidad de encontrar nuevos candidatos a albergar vida.

Fuente: EFE, 12-1-12

![]()

-Explosiones en miniatura para un desafío biológico

Disparos cortísimos de un láser de un billón de vatios para destruir nanocristales en explosiones diminutas: es algo que puede parecer sacado de una novela futurista, pero en realidad es una aplicación de unas nuevas y poderosas máquinas que está causando revuelo en la biología por las expectativas que abre. Conocer la estructura atómica en tres dimensiones de las proteínas, los bloques básicos de las funciones vitales, es uno de los desafíos más importantes que todavía tiene planteados la biología, e incluso hay concursos mundiales para estimular su resolución. Es básico, por ejemplo, conocer cómo es una proteína de membrana de una célula para saber cómo se engancha el virus del sida para infectarla y poder desarrollar medicamentos que lo impidan.

Pese a los avances, muchísimos, en los últimos 50 años y recientes herramientas como los sincrotrones, aún queda bastante camino por andar y por eso un nuevo tipo de láser, XFEL, que ya funciona en Estados Unidos y que se está construyendo en Europa, da razones para el optimismo. Su secreto es que emite ráfagas de pulsos más cortos y de mayor energía, lo que teóricamente da mucha mejor resolución.

|

Un cristal de proteína iluminado por un pulso ultra intenso del láser de rayos X, lo que permite inferir la estructura molecular por la técnica de difracción. / / CFEL / DESY |

La primera confirmación para este optimismo proviene de un experimento realizado en el láser de rayos X del laboratorio estadounidense SLAC por un equipo internacional liderado por científicos del laboratorio europeo DESY. Con pulsos de solo 30 femtosegundos (un femtosegundo es un tiempo inimaginablemente corto equivalente a 10 elevado a -14) han conseguido obtener información estructural de nanocristales del complejo Fotosistema I a pesar de que los destruye instantáneamente con su enorme energía por centímetro cuadrado. Es el pulso más corto que se ha conseguido hasta ahora y los resultados son sorprendentes. La técnica básica es la misma que utilizaba para intentar desentrañar la estructura del ADN hace 50 años Rosalind Franklin, que encaminó a Watson y Crick hacia su ¡Eureka! de la doble hélice. Se radian cristales con rayos X y se obtienen patrones de difracción que permiten deducir la estructura tridimensional de la muestra. “La difracción de rayos X es quizás la técnica que más ha influido en la biología molecular”, explica José María Valpuesta, experto en estructuras moleculares y director del Centro Nacional de Biotecnología. “Sin embargo, está claro que su uso tiene un cuello de botella, la generación de cristales”. El problema es que de muchas moléculas no se obtienen cristales de tamaño suficiente para ser irradiados, incluso con las fuentes de rayos X de alta energía como son los sincrotones. Pero también está el problema de la destrucción de la muestra antes de poder extraer la información. “Un gran problema técnico planteado, a medida que aumentó la energía aplicada en los sincrotrones de tercera generación, es el deterioro de la muestra expuesta a la radiación”, recuerda Cele Abad-Zapatero, experto en estructuras de proteínas. “Algunos investigadores vieron con escepticismo el papel de los láseres de rayos X en la resolución de estructuras biológicas, dada la gran cantidad de energía por unidad de área que estas fuentes pueden concentrar en nanomuestras, que resultarían vaporizadas”. Por eso, la sorpresa ha sido grande. Con pulsos más largos de lo que se creía imprescindible, que bombardean un chorro, de cuatro micras de diámetro, de nanocristales en un medio líquido, se ha obtenido buena información de muestras que, paradójicamente, resultan destruidas antes de que termine el pulso. Aunque todo sea física y química, el proceso ya no es el mismo que en los sincrotrones, dicen los científicos, liderados por Anton Barty y Henry Chapman, al presentar su trabajo en Nature Photonics. |

“La clave de los resultados inesperados que hemos tenido es la cristalinidad”, explica Chapman. Debido a la estructura cristalina (regular) los rayos X no se dispersan de forma uniforme en todas las direcciones y el patrón obtenido se forma antes de la explosión de la muestra, como si el pulso fuera más corto.

“En un sincrotrón todo sucede más despacio y hay tiempo suficiente para que se produzca daño en los enlaces químicos”, añade Barty. “En un láser de rayos X la muestra se convierte en plasma en pocos femtosegundos. Durante las primeras fases de la explosión los átomos se quedan en su sitio, debido a su propia inercia y se puede registrar la estructura”.

“El desarrollo de esta nueva fuente de radiación supone un avance enorme en muchos campos, pero desde luego en la cristalografía de rayos X”, dice Valpuesta, quien concluye: “Esta técnica puede teóricamente utilizarse sobre moléculas no cristalizadas, con técnicas tomográficas, lo que, de conseguirse, abriría un campo casi infinito para la determinación estructural de cualquier tipo de molécula sin necesidad de ser cristalizada”.

“El trabajo parece un avance técnico cualitativo importante”, señala Abad-Zapatero. “Abrirá las puertas a la obtención de estructuras biológicas difíciles de cristalizar, entre ellas las proteínas de membrana, y permitirá mantener el crecimiento del Banco de Datos de Proteínas, que ya almacena 77.000 estructuras, para encarar problemas biológicos cada vez más difíciles de resolver y de mayor relevancia científica y médica”.

Fuente: elpais.com, 11-1-12

![]()

-España bate su récord en trasplantes

España, líder mundial en trasplantes, superó en 2011 todos sus registros. El más indicativo, la tasa de donantes, llegó a 35,3 personas por millón de habitantes. Esto supone que se ha roto la tendencia a la baja de los últimos años (en 2010 la tasa fue de 32, y en 2009 de 34,4). Solo una vez, en 2005, se había pasado de 35 (ese año fue de 35,1).

En números absolutos también se ha batido el récord de donantes: fueron 1.667, frente a los 1.502 y 1.606 de los dos años previos. De acuerdo con los datos que ha presentado la ministra de Sanidad, Ana Mato, en una comparecencia sin preguntas, se han superado por primera vez los 4.200 trasplantes, con un incremento del 11,8% y casi 500 intervenciones más respecto al año anterior. También se han alcanzado máximos históricos en trasplante renal, hepático y de páncreas. Han bajado los de pulmón y los de corazón.

Uno de los aspectos donde más se ha mejorado ha sido en los trasplantes de donante vivo, con un incremento del 30% hasta llegar a los 312. Esta es una de las vías que la Organización Nacional de Trasplantes (ONT) que dirige Rafael Matesanz está promocionando como una medida de acabar con el estancamiento en la actividad de los últimos años, debida, sobre todo, a la disminución de los accidentes de tráfico, que al inicio de la actividad de la ONT eran la fuente principal de donantes. Esto ha supuesto un envejecimiento paulatino de la edad media de los donantes. Si en 1992 era de 34,5 años, ya está en 58,2. Por primera vez más de la mitad de las donaciones (53,7%) eran de personas mayores de 60 años. Mientras que descendió el número de donantes menores de 30, un 5,7% del total. Para Matesanz este es el patrón “de un país muy desarrollado”.

El aumento de la seguridad vial ha supuesto un envejecimiento paulatino de la edad media de los donantes. Si en 1992 era de 34,5 años, ya está en 58,2. Por primera vez, más de la mitad de las donaciones (53,7%) eran de personas mayores de 60 años. En paralelo ha descendido el número de donantes menores de 30, un 5,7% del total. Para Matesanz, este patrón de edades es propio “de un país muy desarrollado”. Otro aspecto que influye en el aumento de las donaciones es la disminución de las negativas familiares. Esta es otra de las cuestiones en las que más se trabaja, por ejemplo formando a los coordinadores y al personal de enfermería para que sepan aproximarse a personas de otras culturas y religiones. Aun así, la tasa de negativas está en el 15,3%. En 2010 era del 19%. Ana Mato atribuyó los buenos datos a los españoles que “en esta época de crisis económica y social han dado un ejemplo de solidaridad”

En términos absolutos, las autonomías en las que más donaciones se han producido en 2011 han sido Andalucía (308) y Cataluña (238) —algo lógico porque son las más pobladas—. En términos relativos a su población encabezan la lista Cantabria, con 67,8 donantes por cada millón de habitantes; La Rioja (62,5) y Asturias (46,3).

Precisamente el Hospital Central Universitario de Oviedo es el primero entre la lista de los centros que más donantes por muerte encefálica han conseguido el último año: alrededor de 50, según la coordinadora de trasplantes del centro, Dolores Escudero. “Este tipo de fallecimiento es más conocido como muerte cerebral”, y tiene la “ventaja” de que es más “predecible”: normalmente los pacientes están en las unidades de cuidados intensivos (UCI), por lo que solo hay que determinar el momento de retirarle la respiración asistida, y el equipo puede estar mejor preparado para mantener los órganos hasta el momento de su extracción. Por eso, tradicionalmente, este tipo de fallecimientos ha sido “la clave de todo sistema de trasplantes”.

Curiosamente, el concepto de muerte encefálica es algo relativamente nuevo. “Se estableció en 1968”, indica Escudero. “Lo tradicional era que una persona muera porque se le para el corazón; por eso se dice que la muerte encefálica es un producto moderno de los cuidados intensivos”, dice la médica.

Su peculiaridad hizo que, sobre todo al principio, el proceso de conseguir la donación fuera muy difícil. Las tasas de negativas del 20% o más eran habituales, y aún lo son en muchos países. “Cuando empecé había muy poca cultura sanitaria. La gente negaba la muerte. ‘Si está caliente, si respira”, nos decían. “Y había que explicarles que estaba caliente porque lo manteníamos así artificialmente, que parece que respira porque está intubado y ayudado mecánicamente”. Hoy día “ya todo el mundo entiende lo que es un electro plano”.

El problema al que se enfrentaba la ONT es que este sistema estaba mostrando síntomas de agotamiento. El modelo español no crecía. Y por eso la organización ha buscado otros métodos para aumentar la tasa, ya que no debe olvidarse que, pese a las prometedoras cifras (o, quizá por ellas: en los países donde no hay posibilidad de recibir un órgano no existen listas de espera al respecto), a finales de 2011 había 5.484 personas esperando un trasplante (en 2010 eran 5.760).

Estos intentos han llevado a fomentar el trasplante de vivo (entre familiares o conocidos), y el del buen samaritano (donante altruista que cede uno de sus riñones o parte de su hígado). También a una versión mezcla de ambas, como los trasplantes en cadena. Pero estos programas, con ser útiles, tienen un recorrido limitado.

Por eso la última apuesta de la ONT son las donaciones con la muerte en asistolia. El centro de referencia en este campo es el Clínico de Madrid. El coordinador de trasplantes del hospital, José Ramón Núñez, explica que es “el concepto de muerte más natural: el corazón que se para”. El problema es que es más imprevisible, por lo que “todo tiene que hacerse en cuatro horas: certificar la muerte, localizar a la familia, conseguir el permiso y extraer los órganos”.

En cambio, tiene una ventaja: la edad media de los candidatos es muy baja: “Son jóvenes, mucho de ellos deportistas. Un caso claro hubiera sido el futbolista Jarque, gente que tiene un paro cardiaco a veces incluso haciendo deporte”, indica el médico.

El Clínico realizó el año pasado alrededor de 45 o 50 trasplantes con este tipo de donante, y colabora para que haya unidades en otros centros, como el hospital de Granada, el Universitario de Oviedo (donde trabaja Escudero) o el Clínic de Barcelona. Además, se ha descubierto una cosa: salvo el corazón —que en este tipo de fallecimientos no se puede reutilizar—, por la naturaleza más joven y sana de los donantes, los otros órganos funcionan mejor cuando se trasplantan.

En lo que Escudero y Núñez coinciden es en la importancia del momento de pedir a la familia los órganos del fallecido. Núñez cree que en las muertes en asistolia, a pesar de que todo es más rápido —a veces hay que empezar por localizarlos— es más fácil. “La gente que lleva mucho tiempo en un hospital desarrolla cierto rechazo”, dice. Eso sí, afirma Escudero: “A pesar de lo duro que sea a veces, ese momento te pone en contacto con lo mejor del ser humano: un familiar que es capaz de superar su dolor y decir que sí”.

Fuente: elpais.com, 10-1-12

![]()

-Una tortuga gigante extinta hace 150 años "resucita" en Gálapagos

«Hasta donde sabemos, este es el primer

descubrimiento de una especie por medio del seguimiento de las huellas genéticas

dejadas en los genomas de su descendencia híbrida», ha explicado el investigador

Ryan Garrick. Las tortugas de Galápagos son famosas por su influencia en las

ideas de Charles Darwin sobre la evolución por selección natural. Pero también

son impresionantes en sí mismas: pueden llegar a pesar más de 400 kilos, llegan

a medir casi dos metros yviven más de 100 años en la naturaleza. Hoy en día,

varias de las trece especies que todavía sobreviven se consideran en peligro de

extinción. De hecho, el movimiento de las tortugas de una isla a otra por los

piratas y los balleneros no era raro durante el siglo XIX, dice

Garrick, y su equipo sospecha que los ejemplares de Floreana habían

sido trasladadas al norte de Isabela años antes. Esos once híbridos

parecen ser los últimos vestigios genéticos de un linaje evolutivo

único en la naturaleza.

Fuente: abc.es, 9-1-12

Las C. elephantopus fueron encontradas originalmente solo en la isla Floreana,

donde se presume que desaparecieron poco después del viaje histórico de Darwin a

las Islas Galápagos en 1835. Sin embargo, los genes de especies extinguidas

recientemente pueden vivir en los genomas de los ejemplares de ascendencia

mixta. El grupo de Yale había detectado antes los primeros vestigios del extinto